Mudanças entre as edições de "Distant reading e strumenti della linguistica computazionale applicati a testi storici"

| Linha 91: | Linha 91: | ||

Per quanto riguarda l’ambito storico, invece, una piattaforma online molto usata a livello di annotazione è ''Recogito''. Questa è nata principalmente per annotare luoghi, ma, dato il suo successo, è stata sviluppata la possibilità di annotare anche persone, eventi e relazioni. Attualmente, si possono effettuare tre tipologie di task sia manuali che semi-automatici che riguardano: | Per quanto riguarda l’ambito storico, invece, una piattaforma online molto usata a livello di annotazione è ''Recogito''. Questa è nata principalmente per annotare luoghi, ma, dato il suo successo, è stata sviluppata la possibilità di annotare anche persone, eventi e relazioni. Attualmente, si possono effettuare tre tipologie di task sia manuali che semi-automatici che riguardano: | ||

| + | # il riconoscimento di entità nominate di persone o luoghi; | ||

| + | # la classificazione di persone o luoghi; | ||

| + | # la georeferenziazione; | ||

| + | |||

| + | Un esempio di testo annotato con ''Recogito'' è il secondo libro dell’Iliade di Omero (figura 6): | ||

| + | |||

| + | [[Arquivo:InPifferi9.png|600px|thumb|center|'''Figura 6. Esempio di annotazione con Recogito – Iliade''']] | ||

}} | }} | ||

Edição das 22h34min de 31 de março de 2021

Il linguaggio umano (o linguaggio naturale) è lo strumento più immediato e duttile di cui disponiamo per creare e comunicare contenuti relativi a ogni tipologia di argomento e disciplina. Negli ultimi decenni, con l’avanzare dell’informatica, si è sfruttata, sempre di più, la possibilità di utilizzare il computer come macchina intelligente in grado di memorizzare ed elaborare enormi quantità di dati (strutturati e non) per renderli disponibili come informazioni. In questo contesto, si è fin da subito resa evidente la possibilità di indagare più facilmente testi di diverso dominio e varietà linguistica, attraverso metodi e strumenti computazionali per riuscire a cogliere aspetti non quantificabili attraverso un’attenta lettura del testo da parte dell’uomo (nota come close reading).

Le prime applicazioni del calcolatore allo studio di testi storici, filosofici e letterari si sono avute nel lavoro pionieristico di padre Roberto Busa che, presso il Centro per l’automazione dell’analisi linguistica di Gallarate, realizzò il primo corpus elettronico delle opere di Tommaso d’Aquino (il cosiddetto Index Thomisticus, che conta circa dieci milioni di parole) e un programma per la loro esplorazione attraverso le concordanze, cioè per mezzo di una lista delle occorrenze di una parola presentata nel suo contesto linguistico. Il suo lavoro diede avvio a una vera e propria nuova disciplina, oggi nota come linguistica computazionale, che oggi prevede anche lo sviluppo di programmi per lo spoglio elettronico dei testi, il calcolo della frequenza delle parole, la compilazione di indici e la creazione di repertori lessicali elettronici.

Questi strumenti innovativi permettono una nuova modalità di lettura dei testi, il cosiddetto distant reading, proposta da Franco Moretti in La letteratura vista da lontano (2005) come alternativa al close reading. Come illustra Moretti, sostituire il binocolo alla lente d’ingrandimento ha diversi vantaggi, in quanto dà la possibilità di estrarre elementi informativi rilevanti dal testo e riconoscere rapporti, somiglianze e pattern con altri documenti che non emergerebbero attraverso una lettura più ravvicinata, in quanto il lettore sarebbe offuscato dai troppi dettagli. In questo modo, la distanza dell’oggetto analizzato, indagata tramite analisi quantitative computazionali, consente di avere una visione completa del libro e dell’autore, permettendo di confermare o confutare ipotesi formulate in una prima fase di lettura ravvicinata, che risulta sempre utile e necessaria per comprendere meglio il focus dell’analisi e capire in che direzione orientare la ricerca.

Uno studio computazionale di questo tipo dà anche la possibilità di comparare in maniera più rapida la trattazione di diversi argomenti da parte di più scrittori (o anche di uno stesso autore in diversi periodi di tempo), mettendo a confronto i contesti d’uso delle parole caratterizzanti un certo dominio.

Così, ad esempio in una ricerca storica, diventa più semplice estrarre dati semantici da fonti attendibili, indagare come viene argomentato un determinato concetto in differenti pensatori di una stessa epoca o di epoche distinte oppure attribuire un determinato documento a un certo autore sulla base dell’analisi del suo stile.

Índice

Profilazione linguistica

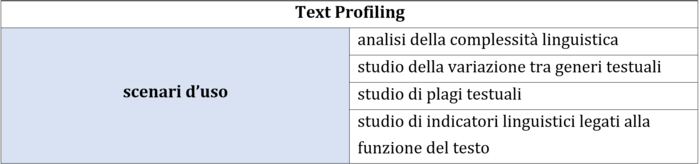

Quest’ultimo compito è reso possibile attraverso il cosiddetto linguistic profiling, cioè attraverso un processo di estrazione di una vasta gamma di parametri di descrizione linguistica, al fine di ricostruire il profilo di un autore o di un testo. I possibili scenari di applicazione, riportati nella tabella 1 e 2, si possono dividere in due gruppi:

- la profilazione del testo;

- la profilazione dell’autore;

In entrambi gli scenari, si possono ricavare, in maniera automatica, un numero notevole di tratti per ciascun livello di annotazione linguistica. In particolare, è possibile estrarre:

- a livello di profilo di base: il numero totale di periodi in cui si articola il testo, il numero totale di parole (tokens), la lunghezza media delle frasi calcolata in termini di numero di parole per frase, il numero medio di caratteri per parola.

- a livello di profilo lessicale: l’indice di ricchezza lessicale come il rapporto tra le parole tipo e unità (TTR) e la tipologia di vocabolario utilizzato.

- a livello di profilo morfosintattico: la distribuzione delle principali parti del discorso e la densità lessicale calcolata come il rapporto tra le parole piene (nomi, verbi, aggettivi, avverbi) e il numero totale delle parole.

- a livello di profilo sintattico: l’articolazione interna del periodo.

Analizzando la distribuzione di queste caratteristiche si può tracciare il profilo linguistico di un autore o di un testo e comprendere quali sono le varietà linguistiche, i generi testuali trattati o, più in generale, lo stile di scrittura.

Profiling-UD

Un’applicazione, sviluppata dall’ItaliaNLP Lab del CNR di Pisa, per realizzare una profilazione linguistica è Profiling-UD. Questa permette di estrarre molteplici tratti del testo, che si estendono su diversi livelli di descrizione linguistica.

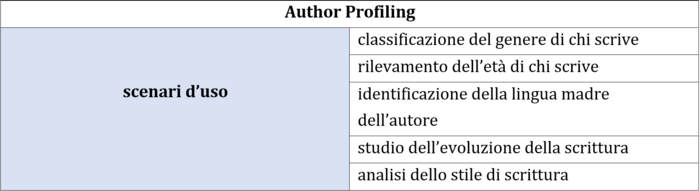

Lo strumento implementa un processo che si articola in due stadi: in prima istanza viene eseguita un’annotazione e solo successivamente una profilazione linguistica. Il primo passo, ossia l’annotazione linguistica, è eseguito per mezzo di UDPipe, una catena di annotazione automatica che include i linguaggi dell’iniziativa Universal Dependencies (UD) [1] e permette di eseguire tutti gli step tipici del pre-processing (illustrati in figura 1): la suddivisione in frasi, la tokenizzazione, la lemmatizzazione, l’annotazione delle parti del discorso e l’annotazione sintattica a dipendenze.

Il secondo passo, invece, prevede l’estrazione, dall’output dei diversi livelli di annotazione linguistica, di circa 130 caratteristiche rappresentative della struttura sottostante al testo. Queste caratteristiche catturano un ampio numero di tratti che vanno da proprietà più superficiali (come la lunghezza delle parole o delle frasi) a più profonde (come le informazioni morfosintattiche e sintattiche).

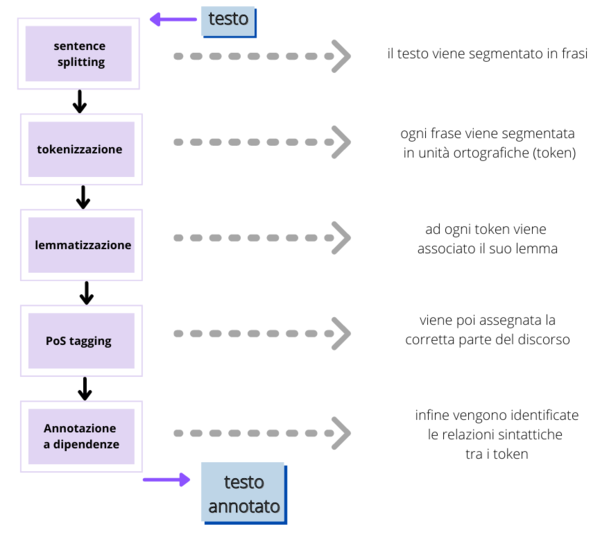

Nell’interfaccia web (http://linguistic-profiling.italianlp.it/), come illustrato in figura 2, viene data la possibilità sia di caricare uno o più file in formato .txt (con codifica dei caratteri UTF8), sia di incollare direttamente il testo da analizzare all’interno della piattaforma.

Prima di procedere con l’esecuzione, è anche richiesto di specificare il linguaggio del testo, il tipo di analisi da svolgere (per frase o per documento) e se il testo è già stato pre-segmentato (presentando frasi distinte su righe separate).

Come accennato in precedenza, l’annotazione del testo viene eseguita da UDPipe, sfruttando i modelli UD disponibili. Nel caso in cui vi sia più di un modello, viene scelto automaticamente quello addestrato su una treebank[2] di più grandi dimensioni.

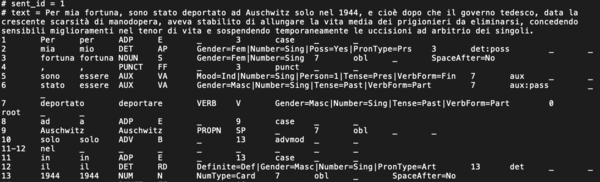

Per ciascun testo analizzato, è possibile scaricare l’annotazione linguistica in formato CONLL, in cui per ogni token sono riportati il lemma, due livelli di parti del discorso (uno a livello di dettaglio più superficiale e uno più approfondito), i tratti morfologici (numero, genere, persona, modo, tempo o superlativo), l’ID della testa sintattica e il tipo di dipendenza.

Di seguito si riporta un esempio:

Il testo automaticamente annotato è poi usato come input per lo step successivo, cioè la profilazione linguistica vera e propria, basata su un insieme di codici in Python che definiscono delle regole per estrarre e quantificare delle proprietà formali.

L’output di quest’ultimo step è rappresentato da un file .csv, contenente una tabella che, dato un testo, per ciascuna caratteristica monitorata riporta il valore corrispondente. Nella figura 4 si riporta un frammento di un esempio di tabella:

Per comprendere meglio i valori associati a ciascuna feature considerata, è possibile scaricare una legenda direttamente dalla piattaforma.

Altre possibili analisi

Tra le altre possibili applicazioni utili per l’analisi di una fonte storica corposa, troviamo la Named entity recognition (NER) e il Topic modelling.

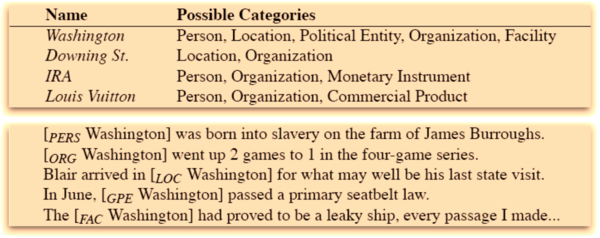

La Named entity recognition (NER) è un task di estrazione dell’informazione che identifica le menzioni di varie entità nominate in testi non strutturati e le classifica in categorie predeterminate, come ad esempio: nomi di persona, organizzazioni, luoghi, date, orari, valute ecc.

Prima della fase di addestramento del modello di NER, è necessario effettuare un’annotazione dei documenti del dominio da analizzare, in modo tale che ad ogni parola sia assegnata l’etichetta della propria entità.

L’annotazione delle entità può essere eseguita tramite alcune codifiche standard. La più nota è la IOB (Inside Outside Begin), in cui il prefisso B sta per Begin (ossia la prima parola di un’entità), I sta per Inside (ossia tutti i token successivi al primo etichettato con B e facenti parte della stessa entità), O sta per Outside (ossia i token non appartenenti a un’entità). Questo tipo di notazione risolve la necessità di codificare anche entità di dominio formate da un gruppo di parole consecutive.

Tuttavia, il limite del task di NER è dato dalla difficoltà del modello nel riconoscere entità che non ha mai incontrato in fase di addestramento. Un ulteriore ostacolo è dato dall’ambiguità del linguaggio naturale che, spesso presenta parole con diversi significati. Ad esempio, lo stesso “Washington” può essere una persona, un luogo, un’organizzazione o un veicolo (vedi figura 5).

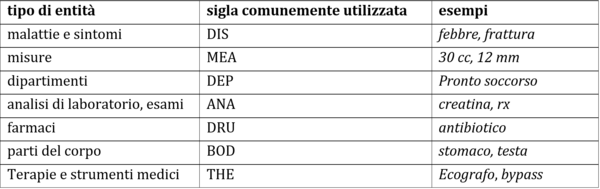

Questo tipo di compito può essere adattato a diversi domini di applicazione. In particolare, è molto utilizzato in ambito biomedico (tabella 3), in cui le entità individuate spesso riguardano farmaci, malattie, parti del corpo ecc.

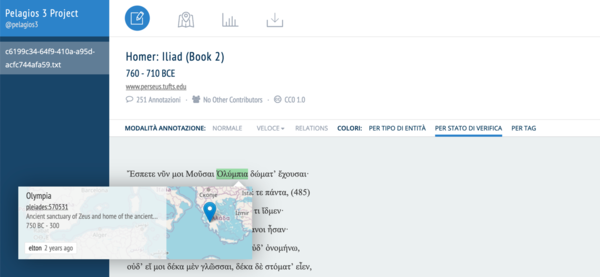

Per quanto riguarda l’ambito storico, invece, una piattaforma online molto usata a livello di annotazione è Recogito. Questa è nata principalmente per annotare luoghi, ma, dato il suo successo, è stata sviluppata la possibilità di annotare anche persone, eventi e relazioni. Attualmente, si possono effettuare tre tipologie di task sia manuali che semi-automatici che riguardano:

- il riconoscimento di entità nominate di persone o luoghi;

- la classificazione di persone o luoghi;

- la georeferenziazione;

Un esempio di testo annotato con Recogito è il secondo libro dell’Iliade di Omero (figura 6):

Bibliografia e sitografia

- ↑ Una lista completa può essere trovata qua: https://universaldependencies.org/.

- ↑ un corpus annotato a livello sintattico.

| Citazione di questo articolo |

| Come citare: PIFFERI, . "Distant reading e strumenti della linguistica computazionale applicati a testi storici". In: CLIOMATICA - Portale di Storia Digitale e ricerca. Disponibile in: http://lhs.unb.br/cliomatica/index.php/Distant_reading_e_strumenti_della_linguistica_computazionale_applicati_a_testi_storici. il giorno: 1/07/2024. |

| Informare errori in questa pagina |