Gestione e trattamento dell’altitudine in funzione dei Sistemi Informativi Territoriali

Índice

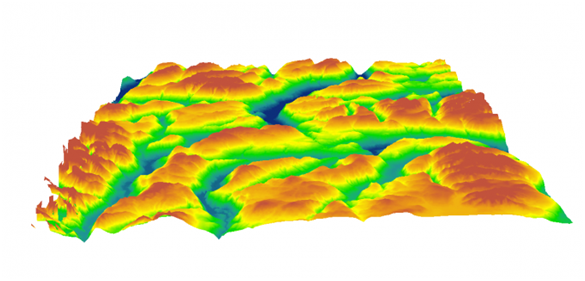

Come si studia l’altimetria

In natura il terreno assume valori differenti di altitudine la quale costituisce l'attributo più importante per lo studio dell'orografia. Di conseguenza, la comprensione e l’elaborazione dell'andamento altimetrico della superficie terrestre rientra nel dominio di competenza dei software GIS, su cui ci si soffermerà nel dettaglio durante questa trattazione. Il trattamento altimetrico di un terreno può essere effettuato attraverso varie tecnologie e approcci compatibili con i software GIS. Questi si distinguono essenzialmente per la forma geometrica scelta per tenere traccia delle misure altimetriche del terreno, ma si strutturano anche a seconda degli aspetti che si vogliono mettere in evidenza. La scelta di una determinata forma si traduce anche in un metodo di trattamento dei dati differente: ad esempio la griglia altimetrica fa normalmente uso di quadrati equivalenti (approccio adottato nei DEM, DSM e DTM) che hanno caratteristiche simili e paragonabili, nell'approccio TIN viene adottata la figura del triangolo senza che questo debba rispettare particolari similitudini geometrica fra i vari triangoli nello spazio. Prima di andare nel dettaglio sugli aspetti tecnici della questione, dobbiamo prendere in considerazione alcuni aspetti preliminari. Per quanto riguarda l’utilizzo specifico che può fare uno storico si possono trovare numerosissime applicazioni per i modelli di elevazione, tanto che il sito [gisgeography.com] dedica una pagina ai mille utilizzi dei DEM, DSM e DTM nei vari ambiti della ricerca. In archeologia, ad esempio, lo studio dell’elevazione può aiutare a ritrovare siti archeologici di antichi insediamenti e per lo studio degli eventi climatici e geologici che hanno portato alla scomparsa di questi siti. Inoltre, è possibile convertire antiche mappe in DEM per analizzare elettronicamente come il territorio è cambiato nel corso del tempo e come questo ha influito sulla costruzione di nuovi insediamenti successivi.

Ci sono anche delle applicazioni per quanto riguarda la divulgazione scientifica, come ad esempio strumenti interattivi per visualizzare spazialmente e temporalmente degli eventi, o portali in cui si mettono a confronto tutte le carte geografiche possedute di una determinata area per studiare gli aspetti peculiari rispetto ad una moderna fotografia satellitare. Insomma. I software GIS sono uno strumento ampiamente utilizzato nello studio della storia e i modelli di elevazione sono uno degli elementi fondanti per comprendere a pieno come un territorio sia cambiato nel corso della Storia. Le applicazioni che riguardano i temi specifici affrontati in questa trattazione, verranno approfonditi man mano.

Informazioni preliminari

A che cosa serve un modello altimetrico

Come già anticipato, le caratteristiche altimetriche di un terreno sono uno tra gli elementi più importanti per fare analisi geomorfologiche. Da diversi anni ormai, lo studio della morfologia del terreno è diventata una pratica adottata anche dagli storici e dagli archeologi. Per fare un esempio pratico, i software GIS possono essere utilizzati con profitto in ricerche che puntano ad individuare la posizione di antichi siti di insediamento, o di intervento umano in generale, poiché spessissimo quando l'essere umano abita, utilizza e frequenta determinate porzioni di terreno vi lascia una traccia indelebile (talvolta invisibile ad occhio nudo), che è possibile rilevare e studiare elettronicamente.

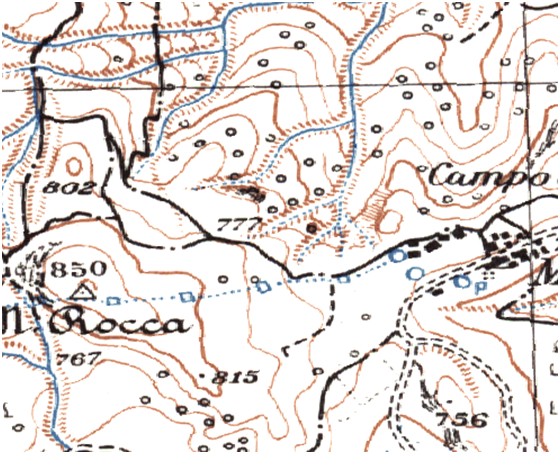

L’altimetria in cartografia

La cartografia tradizionale esprime indicazioni altimetriche attraverso tre elementi fondamentali: le curve di livello (o curve altimetriche o isoipse) le quali uniscono tutti punti ad una determinato livello altimetrico, i punti quotati che indicano l'altitudine di specifici punti sulla carta di cui si ritiene importante segnalare il dato altimetrico che non è catturato da una cura di livello (ad esempio incroci stradali, piazze, vette, depressioni), i triangolini altimetrici che sono dei segni grafici dalla forma di piccoli triangoli acuti che hanno lo scopo di segnalare fossi, dossi, buche e disformità repentine del terreno che non sono catturate dalle curve di livello per la loro natura ridotta. Tuttavia, poiché la carta topografica deve riassumere al suo interno una enorme quantità di dati appartenenti a vari domini, che nella tecnologia GIS vengono suddivisi in vari layer per facilitare la manipolazione, l’informazione altimetrica è riassunta attraverso i dati convenzionalmente ritenuti più importanti. Per questo, ad esempio le curve di livello sono tendenzialmente collocate su livelli di altitudine multipli di 25 metri (5 metri in casi particolari), mentre i punti quotati sono collocati nei luoghi per i quali è rilevante riportare il dato altimetrico. Questi segni convenzionali (curve di livello, punti quotati e triangolini altimetrici) sono elementi senza dubbio “vettoriali” essendo commutabili facilmente in punti e linee, ma non riescono a trasmettere pienamente la ricchezza del dato altimetrico naturale: ogni punto di un terreno ha un suo tipico valore altimetrico e, chiaramente, non è possibile riempire una carta topografica di elementi altimetrici per poter rappresentare uniformemente questo tipo di dato (altrimenti diventerebbe impossibile leggere qualsiasi altro elemento sulla carta). Per questo motivo, la soluzione più logica per rappresentare al meglio le caratteristiche di un attributo continuo (come l'altimetria) sembra essere un modello raster. È necessario aggiungere che, però, il modello TIN ha adottato una soluzione diversa e meno “dispendiosa” rispetto al raster per ovviare al problema della continuità dell’attributo altitudine, restituendo una soluzione vettoriale e non raster. Se ne parlerà più avanti.

Come vengono raccolti i dati di elevazione in un terreno

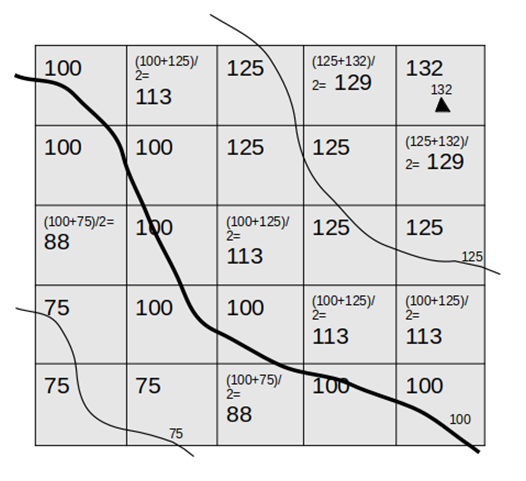

Derivazione dalla cartografia

Le varie tecniche adottate per ottenere i dati utili alla costruzione di un modello di elevazione digitale sfruttano tecnologie molto diverse. La tecnica certamente più banale è quella di derivare le altitudini dalla cartografia tradizionale. Questo processo, seppur risulta essere il più praticabile in assenza di mezzi sfisticati e onerosi (aerei, satelliti, droni) rischia di essere estremamente impreciso e costoso. Impreciso poiché possediamo quote certe soltanto per i punti collocati lungo le isoipse o i punti quotati in sé. Costoso poiché il processo (approssimativo) che ci porta a teorizzare un modello altimetrico deve essere fatto con il supporto umano ad ogni suo passaggio, dato che la cartografia tradizionale è rappresentata da documenti analogici che non sono facilmente traducibili in informazione digitale. La tecnica, come già detto, è piuttosto banale: disponendo unicamente di due segni grafici che ci segnalano precisamente i dati altimetrici (curve di livello e punti quotati) si parte da quelli e si interpolano i dati intermedi tra due dati certi supponendo che l’altitudine aumenti in maniera lineare. Il processo è descritto nella figura numero tre in cui si sta derivando un modello di elevazione digitale a griglia quadrata a partire da una carta topografica tradizionale in cui sono rappresentate tre curve di livello a 75m, 100m, 125m e un punto quotato a 132m. È importante sottolineare che esistono vari algoritmi per derivare le altitudini a seconda del livello di dettaglio con il quale si sta lavorando (dimensioni delle unità della griglia), tuttavia non verranno approfonditi ulteriormente poiché questo approccio, anche se ancora in uso, non presenta elementi di particolare interesse per la finalità della trattazione. Il confronto tra un DEM contemporaneo e uno almeno parzialmente derivato dalla cartografia storica può essere uno strumento molto importante a disposizione dello storico. Naturalmente, come è facile intuire, la scientificità della cartografia storica è altamente approssimativa, poiché solo in età contemporanea si sono iniziati ad utilizzare strumenti abbastanza accurati da poter rappresentare in maniera più o meno equilibrata la superficie terrestre. Tuttavia, la cartografia storica rappresenta l’unico elemento che uno studioso ha a disposizione per poter studiare il modo in cui in passato si rappresentava lo spazio e il territorio. Spesso e volentieri le carte storiche sono anche ricche di simbologia riconducibile alla sfera religiosa o mitologica, ma non per questo sono da considerarsi totalmente inutili. Ricavare un modello di elevazione digitale dalla cartografia storica è, spesso e volentieri, molto complicato, soprattutto per le carte più antiche, ma, attraverso delle operazioni di confronto tra i moderni modelli di elevazione e le antiche carte, è possibile aggiungere del valore alla ricerca. Probabilmente (ma non esclusivamente), le deduzioni più interessanti da poter estrapolare a livello altimetrico dalla cartografia storica solo quelle relative alla linea di costa. L’uomo, nella sua continua e instancabile attività di modellazione del territorio, ha sempre prestato particolare interesse alle coste, dato che lì si concentrava (e spesso si concentra tutt’ora) gran parte delle attività umane (commercio, spedizioni militari, attività portuali, pesca). Studiare le differenze altimetriche che sono intercorse fra il periodo in analisi (attraverso la cartografia storica) e la contemporaneità (attraverso le carte topografiche o i GIS) ci può dare indicazioni di due tipi. Informazioni sulla natura dell’insediamento umano presente in passato: c’era un porto? C’erano dei cantieri navali? Ci sono dei magazzini nei pressi della costa? Fin dove si spingono gli edifici storici rispetto all’attuale linea di costa?. In secondo luogo è possibile ricavare, con l’aiuto di esperti del settore, informazioni relative ai fenomeni climatici e geologici che hanno influenzato una certa area. Così facendo, attraverso lo studio dell’altimetria, potrebbe essere possibile scoprire antichi siti archeologici che sono stati sommersi da alluvioni o frane (si pensi all’antica città bizantina di Napoli, sommersa dal fango) o, addirittura, antichi porti ora sommersi dall’acqua del mare (a causa delle variazioni della temperatura terrestre, o di gravi fenomeni di erosione di costa).

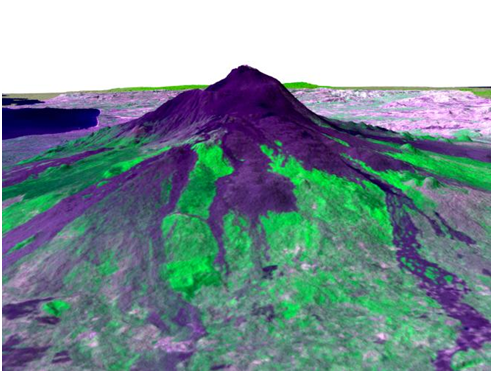

Derivazione da cattura satellitare

Vale la pena di accennare brevemente all’approccio che cattura dati altimetrici attraverso l’utilizzo di tecnologie satellitari, anche se non si entrerà nel dettaglio data la grande complessità tecnica della materia. Tuttavia, dato il crescente utilizzo di questo tipo di supporto, la grande precisione del dato che se ricava e la relativa versatilità è importante come minimo esporre i principi del Synthetic Aperture Radar (SAR). Una similitudine che può spiegare efficacemente il processo cattura di del SAR è quella con i pipistrelli. Questi mammiferi volanti sono quasi totalmente ciechi e muovendosi nella notte non possono certamente fare affidamento sulla luce del sole, per cui percepiscono le distanze tra i volumi attraverso l’emissione di microonde ad alta frequenza le quali rimbalzando sulle superfici e ritornando all’animale, forniscono il dato relativo alla distanza e alla forma degli oggetti circostanti. Il SAR funziona in maniera molto simile inviando dal satellite impulsi di microonde che interagiscono con la superficie in modo diverso a seconda delle caratteristiche del terreno e poi tornano al satellite. Altra caratteristica importante di questa tecnologia è che gli impulsi non vengono generalmente mandati dallo Zenit, quindi da un punto esattamente verticale rispetto all’oggetto da osservare, ma da una certa angolazione.

Ci sono almeno due vantaggi che è importante sottolineare nella tecnologia che implementa il SAR. La prima cosa è che le microonde possono attraversare facilmente le nuvole per raggiungere il terreno e, talvolta, riescono anche ad attraversare il terreno. Questa capacità risulta vantaggiosa rispetto alla fotogrammetria e alla tecnologia Lidar (che verranno affrontate più avanti) che possono incontrare problemi nella cattura del dato se il cielo si presenta particolarmente nuvoloso (specialmente la fotogrammetria). Il secondo vantaggio è che nelle rappresentazioni estratte dal SAR riescono ad evidenziare in maniera estremamente precisa caratteristiche morfologiche del terreno. Questo significa, ad esempio, che è molto facile distinguere in immagini di questo tipo ambienti antropizzati come città o aree industriali dalle aree di campagna, quasi come se si avesse un’immagine satellitare. Questo succede perché gli impulsi emessi dal satellite si comportano in maniera diversa a seconda della natura della superficie che impattano: le superfici molto regolari tipiche delle costruzioni umane permettono al segnale di tornare al satellite con un’intensità quasi integra rispetto a come è stato inviato. Al contrario, gli oggetti naturali, avendo una forma più irregolare e frastagliata, dividono il segnale in più componenti quando vengono colpiti; di conseguenza il segnale di ritorno risulta più debole. Il caso estremo si ha quando le microonde colpiscono superfici piane rispetto alla superficie del terreno. In questo caso il segnale viene respinto in direzione opposte rispetto all’angolazione di impatto e il dato di ritorno sarà quasi inesistente. Tuttavia, nonostante i vantaggi che senza dubbio questa tecnologia offre, c’è da tenere in considerazione gli enormi costi iniziali: la costruzione e il lancio in orbita un satellite sono operazioni che comportano delle spese nell’ordine di centinaia di milioni di dollari[1]. La tecnologia SAR può costituire un elemento interessante da applicare nell’ambito degli studi storici in virtù della sua elevatissima precisione. Il SAR, come anche il LiDAR, è in grado di rilevare minime variazioni nell’altitudine del terreno (nell’ordine di centimetri). Per questo, è possibile analizzare dei pattern ben precisi nel terreno per riconoscere, ad esempio, antiche fondamenta di edifici attraverso la traccia che queste hanno lasciato sulla superficie terrestre (anche se chiaramente la natura dello schiacciamento dipende molto anche dalla natura strutturale del terreno). Inoltre, il SAR, restituendo un output diverso in base alle angolazioni delle superfici che colpisce, potrebbe essere uno strumento utile per riconoscere a colpo d’occhio l’antico nucleo urbano di costruzione romana, medievale, o rinascimentale all’interno di una città che nel frattempo si è espansa molto al di fuori delle mura storiche. Questo proprio in virtù del fatto che è possibile ritrovare caratteristiche tipiche del periodo storico di costruzione anche nell’analisi urbanistica di un centro abitato, o nelle caratteristiche fisiche degli edifici che lo compongono.

LiDAR

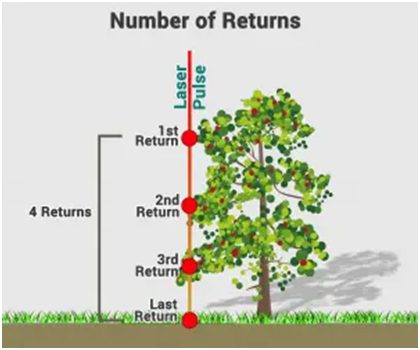

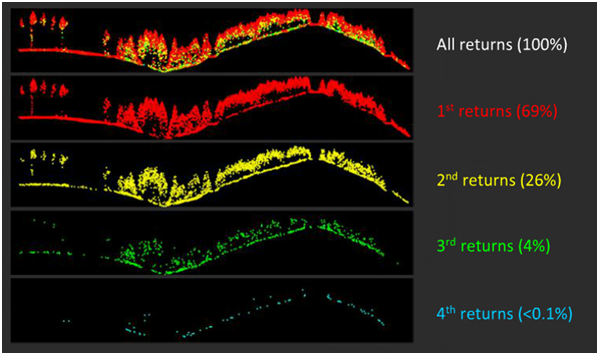

La seconda tecnica utilizzata per raccogliere dati altitudinali del terreno, è il LiDAR (Light Detection and Ranging). Il principio dietro questa tecnologia è piuttosto semplice e decisamente più economico rispetto a mandare un satellite in orbita. Il LiDAR viene condotto da un aereo o da un elicottero dal quale vengono emessi una enorme quantità di raggi di luce (circa centosessantamila pulsazioni al secondo) attraverso uno strumento apposito. Il numero così elevato di emissioni di luce al secondo è necessario per il fatto che i mezzi utilizzati per montare la tecnologia LiDAR hanno una velocità di moto non indifferente e per raccogliere dati precisi è necessario aumentare il più possibile la quantità di altimetrie riportate. È calcolato che per ogni metro/pixel vengano raccolte 15 pulsazioni e il margine di errore della tecnologia è di circa 15 centimetri verticalmente e 40 centimetri orizzontalmente. A questo punto, per ottenere il dato altimetrico, basta calcolare la differenza tra il tempo di emissione dell’impulso e il tempo di arrivo. Così facendo si ottiene una grande nuvola di punti, ognuno dei quali porta con sé un dato, che verrà elaborata da un software per ottenere l’informazione altimetrica del terreno in analisi. Ci sono però delle precisazioni da fare. Il raggio emesso dal LiDAR è abbastanza potente da penetrare, ad esempio, le chiome degli alberi al fine di raggiungere il terreno, tuttavia lo strumento di cattura recepisce un piccolo raggio di ritorno ogni volta che la pulsazione colpisce una superficie solida, anche se poi il raggio riesce comunque a oltrepassare l’ostacolo. Il risultato di questo processo è la possibilità di ottenere più segnali di ritorno per ogni raggio inviato, finendo per avere più dati altimetrici per una singola porzione di spazio aereo. Per la precisione, la maggior parte dei moderni sistemi LiDAR sono in grado di registrare fino ad un massimo di cinque “ritorni” per ogni pulsazione inviata[2]. Nella pratica, questo effetto permette di avere un dato più preciso, ma soprattutto rende più chiara la distinzione tra superfici piane, rade e spoglie da quelle in cui sono presenti forme di vegetazione. Infatti, differenziando i segnali ottenuti dai vari ritorni è possibile generare i vari modelli altimetrici prendendo in considerazione solo alcuni layer di punti. Questa operazione è possibile poiché, come verrà spiegato nel dettaglio successivamente, i DEM (Digital Elevation Model) sono modelli che prendono in considerazione soltanto i dati relativi al solo terreno, senza considerare vegetazione, né costruzioni umane. Per la costruzione di un DEM serve prendere in considerazione solamente i dati di ritorno che provengono dal terreno (l’ultimo ritorno). Per la costruzione dei DSM (Digital Surface Model), invece, vengono prese in considerazione sia le costruzioni umane che gli elementi di vegetazione e quindi vengono recepiti e processati tutti i “ritorni” ricevuti. Per quanto riguarda le applicazioni del LiDAR nella ricerca storica, si possono dire cose molto simili a quelle già trattate per il SAR. Le due tecnologie sono abbastanza simili nella struttura di base e differenziano principalmente per il mezzo sul quale sono implementate. Vale la pena, però, fare riferimento ad un vantaggio del LiDAR rispetto sia al SAR, ma anche rispetto alla fotogrammetria. Come già specificato, il LiDAR si dota di un raggio di luce in gradi di oltrepassare il manto della vegetazione ed arrivare direttamente al terreno, pur mantenendo il dato della vegetazione stessa. Questo permette di rilevare dati del terreno anche se si è all’interno di un bosco o di aree incolte. Sicuramente questo importante vantaggio può aiutare gli archeologi o gli storici a studiare le caratteristiche del terreno anche in quelle aree difficilmente raggiungibili o sulle quali è difficili fare rilevazioni a causa della fitta vegetazione. Per questo è possibile rinvenire ruderi di antichi edifici, antiche strade, tumuli o altre modificazioni antropiche del terreno senza doversi recare fisicamente in luoghi difficilmente raggiungibili o molto lontani[3].

Fotogrammetria aerea

Uno strumento molto usato fino a pochi decenni fa e che sta lentamente lasciando il posto al LiDAR è la fotogrammetria. Questa tecnica è stata teorizzata già a metà ottocento, anche se poi è stata ampiamente utilizzata solo a partire dalla prima guerra mondiale, quando tutte le tecnologie a disposizione utili a carpire informazioni strategiche sulle operazioni nemiche furono messe in campo. La fotogrammetria è uno strumento che si basa su un principio molto intuitivo che è anche alla base della vista. Quando si fissa un qualsiasi oggetto che si trova perpendicolare rispetto al nostro corpo, di quell’oggetto riusciremmo a percepire soltanto due dimensioni senza poterne osservare la profondità. Tuttavia, se potessimo disporre di una foto dello stesso oggetto presa da un’altra angolazione e se avessimo dei punti di riferimento certi di cui conosciamo le dimensioni, potremmo facilmente orientarci su tutte e tre le sue dimensioni. Lo stesso principio vale per la fotogrammetria: disponendo di almeno due fotografie dello stesso elemento da due angolazioni diverse e avendo a disposizione dei punti di riferimento noti, è possibile stabilire l’altitudine di quell’elemento. La fotogrammetria è uno strumento ancora più semplice del LiDAR anche se molto meno preciso e sofisticato. Anche in questo caso il mezzo preferito è l’aereo, tuttavia nel tempo si sta affermando sempre di più la fotogrammetria satellitare o quella condotta attraverso droni (assai più economici rispetto ad un aereo). In questo caso non si utilizzano dei dei laser, ma semplicemente delle specifiche macchine fotografiche vengono montate sul mezzo e vengono programmate in modo da scattare fotografie in lassi di tempo definiti. Il risultato di questa operazione è un mosaico di numerose fotografie che devono essere assemblate secondo regole molto precise (non a caso questo lavoro viene fatto da software molto potenti che sono in grado di gestire migliaia di fotografie contemporaneamente). Nonostante i suoi vantaggi pratici, la fotogrammetria ha dei limiti non indifferenti. Innanzitutto essendo una tecnologia basata sulla rappresentazione fotografica, la fotogrammetria è soggetta a problemi come le oscillazioni del mezzo che possono provocare immagini di bassa qualità, o come la traiettoria del mezzo che deve essere il più possibile precisa rispetto ad un asse ideale lungo il quale si stanno raccogliendo le fotografie, per riuscire a raccogliere dati di qualità. Una seconda limitazione è che, al contrario del LiDAR, la fotografia chiaramente non penetra attraverso la vegetazione. Da qui si deduce che da una rilevazione fatta con fotogrammetria non si può ricavare un DEM, ma solo un DSM, non potendo penetrare attraverso la vegetazione. Potrebbe risultare banale ricordare che la fotografia risulti essere un’invenzione piuttosto recente se la si confronta con l’intero corso della storia umana. Tuttavia, i documenti fotografici riescono ad essere un elemento fondamentale per il lavoro dello storico che deve documentarsi su eventi accaduti dalla fine del XX secolo in poi. Come già accennato la fotogrammetria è stata utilizzata a partire dalla Grande Guerra per scoprire informazioni militarmente importanti sulle postazioni del nemico, anche perché l’aereo è una tecnologia ancora più giovane della fotografia. La fotogrammetria storica, intesa in senso ampio, includendo anche tutta la fotografia aerea realizzata a fini di studio del territorio, perciò, può costituire un elemento di fondamentale importanza per quanto riguarda gli studi di storia contemporanea. Innanzitutto, dato che si è discusso del suo utilizzo per applicazioni belliche, è molto probabile che prima di un bombardamento aereo ci fossero dei velivoli che studiassero le aree da attaccare in anticipo per individuare i luoghi strategici da neutralizzare. È verosimile anche che lo stesso procedimento possa essere avvenuto per analizzare gli effetti che un attacco ha avuto su un’area. Queste fonti, anche se il più delle volte non costituiscano delle vere e proprie fotogrammetrie aeree scientificamente accurate come le intendiamo oggi, rappresentano comunque dei documenti importati per dedurre informazioni su come fossero delle aree urbane prima di (ad esempio) un bombardamento (o di un qualsiasi evento storico impattante per un territorio), sulle aree bombardate, ma anche per fare un confronto con la fotogrammetria contemporanea al fine di analizzare l’evoluzione e lo sviluppo di un centro abitato su un arco temporale. Questo è possibile anche grazie al fatto che operazioni di raccolta di fotografie aeree vengono condotte in maniera abbastanza regolare nel corso del tempo, anche se a grandi distanze. In sintesi la fotogrammetria, che non è altro che un particolare utilizzo della fotografia aerea, può costituire un documento d’archivio fondamentale per studiare le vicende storiche che un particolare territorio ha attraversato nella storia dell’ultimo secolo e costituirà un documento ancora più prezioso man mano che si va avanti nel tempo.

DEM, DSM, DTM e TIN

Si è già accennato al fatto che i DEM utilizzino un approccio raster per risolvere la complessità che emerge dalle variazioni altitudinali del terreno. Resta da capire quali siano le caratteristiche di questo approccio per stabilire infine i suoi vantaggi e i suoi svantaggi.

I vantaggi e i limiti del raster per un modello di elevazione

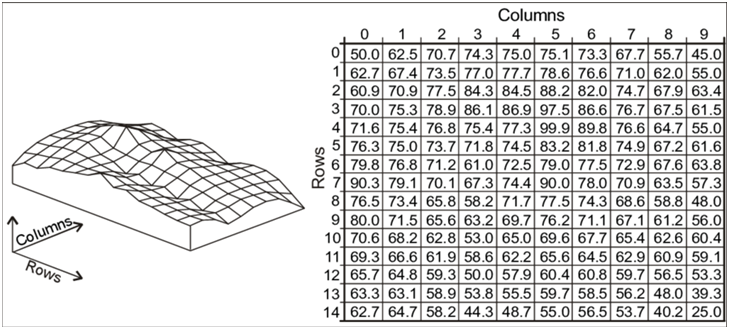

La maggior parte dei fenomeni naturali hanno una distribuzione continua, per cui la loro rappresentazione reale è tale che da assumere valori infiniti[4]. Naturalmente, un fenomeno può assumere valori continui all'interno di un range determinato da limiti naturali (o convenzionali). Ad esempio, l'età di un essere umano non può essere inferiore a 0 e raramente supera i 110. Parallelamente per l'altitudine accade qualcosa di simile: nel pianeta Terra si usa il livello del mare come "quota 0", e i valori possono variare tra i -10994 metri dell'abisso Challenger nella Fossa delle Marianne (punto più profondo della superficie terrestre, rispetto al livello del mare) e i +8848 metri del monte Everest (punto più alto della superficie terrestre, rispetto al livello del mare). Verosimilmente questa ampia varietà di valori (19483 considerando come unità di misura minima il metro) crea dei problemi di rappresentazione perché, in linea teorica, ogni punto della superficie terrestre potrebbe assumere un valore proprio e differente dai punti intorno a lui. Si pensi ad una parete rocciosa molto inclinata: i software GIS, come qualsiasi altro strumento informatico, risolvono questo problema di rappresentazione attraverso la discretizzazione dei fenomeni continui (ad esempio nel modello raster lo spazio viene diviso in forme geometriche areali -i quadrati- che si suppone avere le caratteristiche omogenee al loro interno). Il risultato non sarà una superficie piana inclinata, ma una sorta di scala che possiede un dato altimetrico ad ogni scalino (un po’ come accade naturalmente nel suggestivo Selciato del gigante in Irlanda del Nord). Questo tipo di semplificazione genera, inevitabilmente, un modello imperfetto che limita l'espressione di alcuni dettagli[5]. Discretizzare un fenomeno significa racchiudere un elemento che prima era continuo all'interno di una certa quantità di "cesti" che tendenzialmente dovrebbero riassumere le caratteristiche del loro contenuto. Nel caso del DEM lo si fa con dei quadrati tutti uguali fra loro (mentre nel TIN si adottano triangoli). La scelta di questa forma, però, può creare dei problemi nella rappresentazione di linee del terreno che siano trasversali rispetto alla griglia dei quadrati: l’effetto risultante potrebbe essere una linea spezzata con un andamento a zig-zag anziché una vera e propria linea diagonale. Questo primo svantaggio è seguito da un altro problema: per mappare l’elevazione di un terreno in maniera adeguata (per evitare effetti zig-zag e per riuscire a rappresentare tutte le articolazioni) potrebbe essere necessaria una griglia con un livello di dettaglio molto elevato (una scala molto grande per i quadrati). Questo comporta la gestione di imponenti quantità di dati, soprattutto se è necessario lavorare su un’area di dimensioni importanti. Se vogliamo un livello di dettagli di un metro quadrato (vogliamo avere il dato altimetrico per ogni metro quadrato della superficie in esame) e si sta lavorando su un’area di un chilometro quadrato, il calcolo è presto fatto: è necessaria una griglia di un milione di quadrati che equivale ad un milione di dati altimetrici. È intuitivo comprendere quanto possa essere “costoso” gestire questa enorme mole di dati, soprattutto se sono necessarie operazioni su più layer sovrapposti. In Italia esiste un DEM che comprende tutto il territorio nazionale diviso per sezioni con una risoluzione di 10 m[6]. Questo significa che per l’Italia, che ha un’area di 301340 kmq, esiste una grigia di oltre trenta miliardi di quadrati[7].

Inoltre, c’è da dire che molta di questa informazione potrebbe essere totalmente superflua, sia perché potrebbe non interessare un livello di dettagli così avanzato, sia perché l’unità di misura scelta al momento della data collection potrebbe rendere inutile la raccolta di informazioni su superfici relativamente omogenee (ad esempio se si sta analizzando una pianura la cui variazione altimetrica è inferiore al metro). L’ultimo possibile svantaggio della griglia è l’opposto di quello che si è appena menzionato: una griglia altimetrica con unità di misura non abbastanza dettagliate potrebbe non garantire l’adeguata variabilità della superficie presa in considerazione. Questo problema potrebbe ulteriormente acuirsi in relazione all’algoritmo scelto per l’interpolazione dei dati (picchi o depressioni improvvise su superfici omogenee potrebbero anche essere totalmente scartate)[8].

C’è da ammettere che, almeno nella maggior parte dei casi, per uno studioso di Storia i problemi legati alla complessità computazionale di un modello di elevazione digitale si presentino molto raramente. Questo perché, tendenzialmente, le analisi vengono condotte su aree piuttosto ridotte se le si considera rispetto all’area di una nazione intera. Ciò non toglie che anche lo storico quando si approccia al GIS dovrebbe aver ben presente quali possono essere i limiti di un raster, soprattutto se si devono estrarre delle conclusioni specifiche sull’aspetto altimetrico. Ad esempio, se si è interessati a condurre un’indagine sull’altitudine media in cui una determinata popolazione costruiva i propri insediamenti, è importante conoscere bene il modello di elevazione con cui si ha a che fare: in base all’algoritmo scelto per l’interpolazione dei dati (cioè alla tecnica usata per sintetizzare in un unico dato, tutta l’informazione racchiusa all’interno dell’area di un singolo quadrato) i dati potrebbero variare e soprattutto è fondamentale conoscere la scala del quadrato che compone la griglia. In base a questi due parametri potremmo avere dati altitudinali di due punti registrati nel raster come diversi, ma che nella realtà sono uguali e viceversa. Non bisogna, dunque, cadere nella trappola di credere immediatamente al dato registrato, senza prima aver studiato attentamente il proprio modello e senza aver associato un certo margine di errore alle proprie conclusioni. Questi parametri (algoritmo e scala) dovrebbero essere riportati nella documentazione del raster quando lo si scarica, anche se non è sempre vero. In ogni caso è possibile ricavare l'informazione sulla scala del quadrato semplicemente andando a misurare il lato di un singolo quadrato della griglia in modo manuale, ingrandendo il raster in analisi dal proprio software GIS e utilizzando lo strumento di misurazione. Tuttavia, sfortunatamente non è possibile ricavare manualmente l’informazione dell’algoritmo usato.

Definizioni, vantaggi, svantaggi di DEM, DSM DTM e TIN

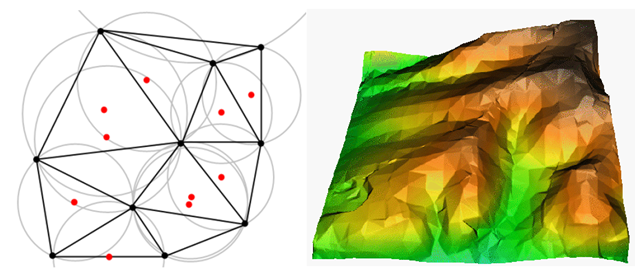

Si è già accennato al fatto che i DEM sono modelli di dati di elevazione che fanno esplicito riferimento alle sole caratteristiche del terreno. Ciò significa che quando si raccolgono i dati per la costruzione di questo modello non vengono prese in considerazione né le strutture umane (ponti, strade, palazzi, dighe, etc…), né gli elementi vegetali (arbusti, alberi, siepi, cespugli). La scelta ricade su ciò che in inglese viene chiamato bare ground perché i DEM sono pensati per studiare le caratteristiche del terreno in sé, senza prendere in considerazione le interazione che possono esserci fra tutti gli elementi presenti sulla superficie. Al contrario, i DSM sono modelli che puntano ad analizzare le interazioni fra gli elementi naturali e gli elementi antropici e sono mezzi fondamentali per analisi urbanistiche ed ingegneristiche. Ad esempio, se si vuole fare un’analisi sull’esposizione solare per la costruzione di un nuovo complesso residenziale, è necessario il supporto di un DSM poiché occorre prendere in considerazione l’orografia del terreno, la vegetazione e altre strutture antropiche che possono influenzare l’irradiazione solare. D’altra parte, ad esempio, se si vogliono studiare i cambiamenti dell’orografia dopo un grave terremoto è necessario prendere in considerazione solamente la superficie terrestre, per cui serve dotarsi di un DEM con una buona precisione. I DTM (Digital Terrain Model), invece, sono modelli che quasi sempre corrispondono ai DEM, mentre da alcuni studiosi sono descritti come delle strutture a parte. In questo secondo caso i DTM rimangono modelli molto simili ai DEM, ma riportano anche alcune caratteristiche del terreno che non sono direttamente riportate nei DEM, come linee di contorno, indicazioni di pendenza (slope in QGIS) ed esposizione. Ai fini di questa trattazione, basti pensare che nella maggior parte dei casi DTM e DEM sono termini usati come sinonimi. A questo punto vale la pena completare questa sezione discutendo il modello TIN. È già stato accennato il fatto che se negli altri modelli il quadrato è la forma che caratterizza la manipolazione dello spazio, in questo caso si usa la triangolazione. Se siamo in un contesto in cui si possiedono numerosi dati relativi alle altitudini del terreno, visualizzabili mentalmente come un piano in cui sono presenti molti punti quotati, invece di racchiudere i dati dentro una griglia, i punti noti si usano come vertici per costruire dei triangoli adiacenti e non sovrapponibili. È chiaro, però, che avendo solo dei punti sparsi su un piano è possibile generare un numero quasi infinito di triangoli, con la possibilità di generare figure poco armoniche che non aiutano il trattamento del dato altimetrico. Per sopperire a questo difetto, nella costruzione dei triangoli si preferisce adottare il criterio di Delaunay secondo cui la circonferenza circoscritta ad un qualsiasi triangolo non deve contenere altri vertici oltre a quelli del triangolo inscritto. Così facendo si massimizzano gli angoli interni del triangolo preso in considerazione e si evitano triangoli piccoli e allungati che potrebbero compromettere la qualità dell’interpolazione. Un’altra caratteristica interessante dei TIN (vantaggiosa rispetto agli altri modelli basati su griglia) è il fatto che la distribuzione delle quote non è omogenea come in una griglia, ma aumenta di densità laddove aumentano i punti noti (presumibilmente nei punti in cui ci sono forti variazioni di quota). Questa dote si può accentuare anche artificialmente eliminando punti noti nelle aree in cui c’è una bassa o nulla variabilità altimetrica (pianure, depressioni o altipiani) in modo da generare triangoli più grandi e meno costosi da gestire. In questo modo si rende più efficiente la manipolazione del dato e si ottimizza la natura dell’informazione. Tuttavia, se i TIN sono molto potenti nel rappresentare aree di terreno frastagliate e variabili, dimostrano minor efficacia quando si vuole prestare più attenzione alle pendenze e alle esposizioni, aspetto in cui i DEM e DSM sono certamente più solidi[9]. Infatti, poiché all'interno dell'area coperta da ogni triangolo il dato della quota si ottiene con un'interpolazione lineare, avviene che all'interno dell'area tutti i punti hanno pendenza costante e tutti i punti hanno esposizione costante.

Bibliografia e sitografia

- ↑ DE SELDING, Peter B., «Canadian Radarsat Constellation To Get $374 Million Cash Infusion», in SPACENEWS 26 agosto 2010, URL: < https://spacenews.com/canadian-radarsat-constellation-get-374-million-cash-infusion/ > [consultato il 1° settembre 2021].

- ↑ LIDAR DATA, GSP 216. Introduction to remote sensing, Humboldt State University, 2019.

- ↑ WERBROUCK, Ilke et al., «Digital Elevation Model generation for historical landscape analysis based on LiDAR data, a case study in Flanders (Belgium)», in Expert Systems with Applications, 38, 7/2011, pp. 8178–8185. In questo studio si utilizza la tecnologia LiDAR per generare due tipi di modelli altimetrici: un TIN e una griglia regolare al fine di ricavare dati utili per lo studio della geoarcheologia.

- ↑ s.v. «Distribuzione Continua», in Enciclopedia della Matematica Treccani, 2013, URL: < https://www.treccani.it/enciclopedia/distribuzione-continua_%28Enciclopedia-della-Matematica%29/#:~:text=Si%20dice%20che%20un%20carattere,relativi%20a%20un%20insieme%20di > [consultato il 1°settembre 2021].

- ↑ HUISMAN, Otto, DE BY, Rolf A. (eds.), Principles of Geographic Information Systems, Enschede, ITC, 2009, p. 64.

- ↑ TARQUINI, Stefano et al., TINITALY, a digital elevation model of Italy with a 10 m-cell size (Version 1.0), Roma, Istituto Nazionale di Geofisica e Vulcanologia (INGV), 2007

- ↑ Sul sito dell’INGV di Pisa è liberamente disponibile in accesso CC 4.0 un DEM per tutta l’Italia con risoluzione 100m.

- ↑ GALLANT, John C., Wilson John, Digital Terrain Analysis in Terrain Analysis: Principles and Applications, Hoboken, John Wiley & Sons, 2000, p. 3.

- ↑ HUTCHINSON, Michael F., GALLANT, John C., Geographical Information Systems, Chapter 9: Representation of Terrain, New York, John Wiley & Sons, 1999, Vol. 1, p. 106.

| Citazione di questo articolo |

| Come citare: PAPA, Sirio . "Gestione e trattamento dell’altitudine in funzione dei Sistemi Informativi Territoriali". In: CLIOMATICA - Portale di Storia Digitale e ricerca. Disponibile in: http://lhs.unb.br/cliomatica/index.php/Gestione_e_trattamento_dell%E2%80%99altitudine_in_funzione_dei_Sistemi_Informativi_Territoriali. il giorno: 26/06/2024. |

| Informare errori in questa pagina |