Natural Language Processing (NLP)

Índice

Storia dell’NLP

Il Natural Language Processing (NLP), nella sua definizione più generale, si riferisce al trattamento automatico del linguaggio mediante l’uso di strumenti elettronici di computazione, ossia di computer. Sotto una certa luce, la Linguistica Computazionale (LC) e l’NLP possono essere concepite come due facce della medesima medaglia. D’altra parte, però, secondo alcuni studiosi questa concezione può essere riduzionistica e semplicistica. Nella Prefazione di Tullio De Mauro al libro di Isabella Chiari Introduzione alla linguistica computazionale, lo studioso sottolinea la necessità di distinguere il piano teorico dal piano applicativo: il primo, è il piano di una teoria o scienza generale tesa all’analisi descrittiva delle lingue mediante l’uso dei computer; il secondo, è il cosiddetto piano dello sviluppo delle tecnologie ingegneristiche e computazionali – nelle parole di De Mauro «di quegli straordinari prolungamenti automatizzati delle nostre mani e occhi e della nostra memoria che sono i computer e le loro applicazioni» [1] . Se nella storia questi due ambiti hanno seguito talvolta un andamento parallelo, ormai i loro percorsi convergono e si intrecciano sempre più intensamente per andare a restituire un resoconto plurale e quindi sempre più fedele alla problematicità di ciò che va sotto il nome di ‘lingua’ e di tutte le sue manifestazioni. Inoltre, se è vero che le riflessioni intorno alla natura del linguaggio e al suo funzionamento hanno radici tanto solide quanto lontane nella storia dell’uomo – dall’antichità fino ad oggi – è altrettanto vero che anche le riflessioni intorno alla creazione di esseri artificiali e linguaggi formali poggiano le loro fondamenta in là nel tempo.

«L’ambizione a creare esseri artificiali, meccanici, che svolgessero azioni solitamente svolte da esseri viventi, animali e uomini, è sempre stata nella fantasia dell’uomo, dalle ideazioni degli ingegneri alessandrini alle teste parlanti medioevali, fino ai veri e propri automi (dal greco autòmatos, «che agisce da sé»), macchine che, sulla base di istruzioni, eseguono un’azione o compiono atti di tipo linguistico» [2].

Infatti, l’episteme filosofica cinquecentesca e seicentesca fortemente influenzata dalle diverse scoperte scientifiche che hanno contrassegnato i due secoli, fa emergere come filo conduttore l’intreccio della riflessione intorno agli automi e le lingue artificiali: da Cartesio, ad Hobbes fino ad arrivare a Leibniz la riflessione filosofica fa emergere sempre di più quelli che sono i tratti comuni tra il linguaggio naturale e il linguaggio algebrico. Tuttavia, è soltanto durante il Novecento, in seno a tutte le riflessioni della logica e della filosofia del linguaggio e a fronte di esigenze politiche e belliche, che si concretizza l’idea di costruire delle macchine capaci di manipolare segni linguistici. Infatti, il primo calcolatore logico programmabile, denominato Colossus per le sue dimensioni, è stato messo a punto dagli inglesi nel pieno della Seconda Guerra Mondiale per decriptare le comunicazioni segrete tra Hitler e i suoi generali – queste ultime, a loro volta, criptate mediante la macchina Enigma.

D’altronde, nello stesso periodo, l’ingegnere e matematico Warren Weaver, autore insieme a Claude Shannon della Teoria matematica della comunicazione del 1949, mise in rilievo le forti assonanze tra l’operazione di traduzione e l’operazione di crittografia: entrambi rappresentano processi di trasmissione e codifica dell’informazione, di «trasposizione di un messaggio da un codice a un altro, esattamente come la trascrizione di un testo scritto in alfabeto Morse o in una scrittura segreta» [3].

Durante la Guerra Fredda la paura della guerra nucleare incentivò la ricerca e lo sviluppo nell’ambito del natural language processing – a cominciare dalla necessità di tradurre la lingua russa scritta e parlata nell’inglese americano. Pertanto, si può dire che l’NLP nasce e si configura focalizzandosi inizialmente sulla traduzione automatica, che per il basso costo d’errore e la rapidità di decodifica rappresentava uno strumento vitale per gli Stati Uniti in termini di costi e benefici di guerra. Il primo esperimento pubblico di traduzione automatica ha avuto luogo nel 1954 all’Università di Georgetown negli Stati Uniti con l’uso di un sistema IBM per la traduzione di un numero ristretto di frasi, per l’appunto, dal russo all’inglese sulla base di un altrettanto ristretto vocabolario di parole. In questa prima fase di sviluppo, infatti, i sistemi di traduzione automatica consistevano nella combinazione di statistiche e regole del linguaggio e soprattutto di tavole di corrispondenza tra le parole di una lingua e il corrispettivo nell’altra lingua. Il risultato elaborato da questi primi sistemi rudimentali non poteva essere altro che una traduzione letterale, molto limitata a cui doveva accompagnarsi un’indispensabile revisione umana.

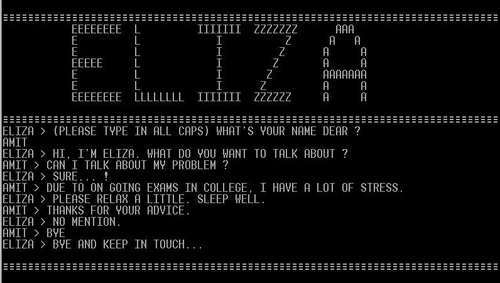

Gli anni che vanno dal 1954 al 1966 sono anni di grande sviluppo per l’NLP, l’AI (Artificial Intelligence) e l’LC. Emblematica in questo senso è la conferenza che si tenne nel 1956 al Dartmouth College nel New Hampshire, durante la quale John McCarthy coniò l’espressione Artificial Intelligence, approfondendone tutte le tematiche ad essa legate [4].4 Nel 1957 Noam Chomsky pubblica il suo libro Syntactic Structure, il cui paradigma modellistico influenzò differenti ambiti – la linguistica teorica, la linguistica computazionale, la filosofia del linguaggio e della mente, le scienze cognitive, etc. Altra data storica è il 1966, la cui importanza riguarda la creazione di ELIZA, primo chatterbot della storia: creato da Joseph Weizenbaum al MIT (Massachussetts Institute of Technology), si trattava di automa per la conversazione con umani, che impersonava una psicologa artificiale. Il funzionamento di ELIZA si fondava sull’analisi del testo e l’individuazione di parole-chiave, usate in seconda istanza per produrre risposte appropriate alle richieste degli utenti. ELIZA riscosse un grande successo – per la sua capacità di dare spesso agli utenti l’illusione di una vera e propria comprensione reciproca – e diede avvio alla creazione di numerosi altri chatterbots – tra gli altri, SHRDLU di Winograd e LUNAR di Woods [5].

Tuttavia, a questa prima fase di grande entusiasmo seguì una battuta d’arresto: nel 1966 l’ALPAC (Automatic Language Processing Advisory Commitee) affermò che i risultati delle ricerche nell’ambito della traduzione automatica avevano delle tempistiche troppo lunghe e non avevano effettivamente portato a dei benefici qualitativi e quantitativi tali da rendere la traduzione automatica più conveniente di quella manuale e umana [6].

Nella seconda metà degli anni ’70, l’NLP torna alla ribalta e riceve una nuova spinta vitale, in un’ottica più realistica e concreta:

«Al semplice confronto lessicale sono affiancate e integrate componenti di analisi morfologica, sintattica e disambiguatori semantici, per consentire alla traduzione in output una maggiore corrispondenza complessiva al testo originale. Il primo dei grandi sistemi di traduzione commerciale di successo, che ancora oggi è utilizzato in molte versioni, fu Systran (acronimo composto di System Translation), sviluppato proprio a partire dagli anni Settanta. Systran nasce come sistema di traduzione diretta dal russo all’inglese, e in seguito introduce moduli complessi di analisi sintattica e lessicale e nuove coppie di lingue. Esso diviene uno dei sistemi più̀ usati anche da organismi internazionali come la Nato, l’aeronautica americana e l’Unione europea, ma anche da aziende come Xerox o General Motors. Sempre negli anni Settanta iniziano a farsi conoscere i primi progetti di traduzione automatica sviluppati in Giappone, paese che ha sempre giocato un ruolo importantissimo nella ricerca in questo settore». [7]

Come si può notare, da questo momento in poi, una grande spinta propulsiva e finanziaria fu data sia da parte di organismi internazionali come la UE, la Nato e l’Onu sia da parte delle grandi multinazionali.

Esistono fondamentalmente due tipi di famiglie di modelli per la traduzione automatica: la prima, è la famiglia dei cosiddetti sistemi basati su regole – rulebased MT (machine translation) – ossia, modelli basati su un insieme circoscritto di regole formali di trascrizione e trasformazione delle unità linguistiche; la seconda, è la famiglia composta dai sistemi probabilistici – ossia, basati su dati disponibili sotto forma di corpora. La prima famiglia ha caratterizzato l’arco temporale che va dagli anni ’50-’70; la seconda l’arco temporale che va dagli anni ’80-’90. Il passaggio dai modelli a regole ai modelli statistici ha segnato anche un cambio di prospettiva sul piano teorico. Difatti, i modelli basati su sistemi probabilistici e statistici, fin dalla loro comparsa, si sono dimostrati molto validi e promettenti in termini di prestazioni e questo ha comportato una revisione delle modalità d’accesso al linguaggio, diverse dalla visione sintattica e combinatoria della lingua tipica del generativismo. La possibilità di poter analizzare la lingua da un punto di vista probabilistico è legato al fatto che la lingua stessa, anche solo da un punto di vista teorico, può essere concepita come un sistema probabilistico che genera sequenze grammaticali di parole. Il fatto che la lingua possa esser concepita come un sistema probabilistico consente la creazione di un modello linguistico stocastico (MLS), o language model, del sistema che genera le sequenze linguistiche. La probabilità che una frase sia enunciata nell’uso è determinata da diversi vincoli linguistici: regole sintattiche, proprietà semantiche, convenzioni d’uso, circostanze pragmatiche. Esiste quindi una stretta relazione tra il grado di grammaticalità di una frase e la probabilità che questa stessa frase venga enunciata. Infatti, i fenomeni linguistici, in quanto prodotti da un sistema probabilistico, possono essere spiegati e quindi previsti attraverso un modello probabilistico costruito a partire da un corpus di addestramento fatto di osservazioni del comportamento del sistema. Queste ultime ci serviranno infatti per stimare quelli che sono i parametri del modello probabilistico, ossia le diverse probabilità che compongono un modello. Il corpus di addestramento di un MLS deve essere un campione rappresentativo dei testi di una lingua. I dati estratti a partire dall’osservazione del corpus di addestramento sono in seguito usati per valutare la probabilità del verificarsi degli eventi prodotti dall’MLS. La bontà del modello è successivamente valutata in base alla sua capacità di prevedere correttamente o meno il comportamento futuro del sistema. Conseguentemente, il modello sarà allora tanto più accurato quanto più sarà in grado di prevedere correttamente quali sono le sequenze grammaticali della lingua dei testi del corpus: ovvero, se sarà in grado di assegnare una probabilità maggiore a sequenze che appartengono alla grammatica della lingua rispetto a quelle che non vi appartengono. Inoltre, il valore del modello risiede anche chiaramente nella sua generalità, ossia nella sua capacità di farci fare previsioni su nuovi dati, diversi da quello su cui è stato addestrato. In ultimo, chiaramente, la generalità del modello dipende a sua volta dalla rappresentatività del corpus di addestramento scelto rispetto al fenomeno da spiegare. In sintesi, questi modelli studiano la lingua per come si manifesta a livello distribuzionale nel suo uso.

Questo approccio mostra anche un cambio di segno teorico ulteriore che, solo a uno sguardo superficiale, può rimanere solo sullo sfondo: con l’affermarsi di questi modelli si assiste a un graduale orientamento dello studio della lingua da un punto di vista esclusivamente formale – tipico del linguista teorico tradizionale – a un punto di vista usage-based. Difatti, una concezione distribuzionale della lingua e dei suoi significati altro non è che un approccio quantitativo e probabilistico alla più teorica affermazione squisitamente wittgensteiniana per cui «Il significato di una parola è il suo uso nel linguaggio». [8]

Oltre che per le motivazioni prettamente teoriche di cui abbiamo appena parlato, il successo dei modelli probabilistici è legato anche a fattori di natura pragmatica: da un lato, il progressivo miglioramento dei computer in termini di potenza di calcolo e memoria, fatto che ha comportato una maggiore capacità e flessibilità dei calcolatori di analizzare e manipolare grandi quantità di dati – anche linguistici; dall’altro, la possibilità di addestrare i sistemi su grandi quantità di dati insieme con l’avvento di internet si accompagnano a una sempre maggiore disponibilità di grandi quantità di dati linguistici in formato elettronico – da cui consegue la possibilità ulteriore di un campionamento sempre più ampio e diversificato di una lingua nel suo uso. Con l’avvento del web e il progressivo miglioramento della rete delle telecomunicazioni ha infatti comportato non solo una crescente disponibilità di materiali linguistici, ma anche l’uso del web stesso come un corpus nel quale poter osservare la lingua nel suo uso.

Per questo motivo, i sistemi attuali sono dei sistemi ibridi che tentano di fare una ricca commistione di metodologie basate su regole formali con metodologie statistiche basate su corpora, in maniera tale sviluppare strategie diversificate e sempre più mirate agli specifici problemi linguistici da affrontare. Questo è ciò che spinge la studiosa Isabella Chiari ad affermare: «La flessibilità dei modelli ibridi è anch’essa un indicatore teorico non marginale che suggerisce una rappresentazione della produzione linguistica come un insieme di strategie (e non come un percorso seriale) adoperabili in relazione a specifiche condizioni linguistiche ed extralinguistiche di utenza». [9]

L’ibridazione dei modelli – che dagli anni ’80 in poi ha caratterizzato una nuova episteme neo-empirista – ha consentito di porre al centro, da un lato, il dato testuale come frutto dell’uso reale e concreto di una lingua, e dall’altro, lo studio delle regolarità distribuzionali delle parole come possibile strumento di ricostruzione semantica. Con le parole dello studioso Lenci:

«Grazie a questo cambiamento di paradigma epistemologico, oggi la linguistica computazionale è in grado di far emergere nuove sinergie tra le scienze umane e le metodologie informatiche».[10]

Applicazioni dell’NLP

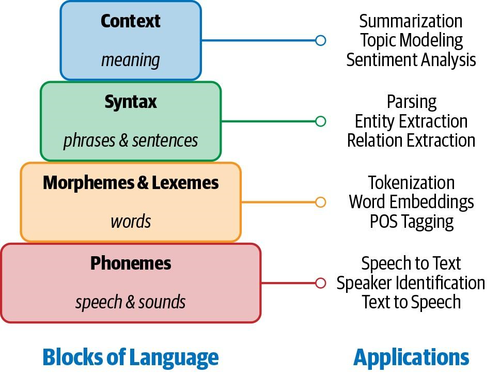

Un’adeguata spiegazione del funzionamento di un sistema di elaborazione del linguaggio naturale passa per una spiegazione dei livelli linguistici coinvolti effettivamente nell’elaborazione del linguaggio. La ricerca psicolinguistica suggerisce come l’elaborazione del linguaggio sia un’attività dinamica, in cui i vari livelli linguistici possono interagire in una varietà di ordini. Difatti, partendo dal fatto che l’obiettivo dell’NLP è un’elaborazione del linguaggio simile a quella dell’uomo e dall’assunto che nella comprensione umana sono coinvolti tutti i livelli del linguaggio, allora si può dire per analogia che più un sistema NLP è capace, più livelli di linguaggio utilizzerà. Vediamo più nel dettaglio i diversi livelli del linguaggio coinvolti nelle sfide delle diverse tecnologie dell’NLP:

- Fonologia: questo livello ha a che fare con l’interpretazione dei suoni corrispondenti alle parole e alle combinazioni di parole. Infatti, ci sono tre tipi di regole usate nell’analisi fonologica: le regole fonetiche, che riguardano i suoni delle parole; le regole fonemiche, che riguardano le variazioni nella pronuncia; le regole prosodiche che riguardano le variazioni di accento e intonazione. In un sistema di NLP i suoni vengono trasformati in segnale digitalizzato per essere interpretati attraverso un particolare modello linguistico.

- Morfologia: questo livello ha a che fare con la natura combinatoria dei morfemi – le più piccole unità dotate di significato. Come gli uomini per afferrare il significato di una parola sconosciuta la scompongono nei suoi morfemi costitutivi, anche i sistemi di NLP costruiscono una rappresentazione del significato a partire dal significato trasmesso da ogni morfema.

- Lessico: a questo livello comincia a svilupparsi in maniera più precisa e disambiguata il significato delle singole parole. L’individuazione del lemma e della corretta part of speech consente di comprendere quale sia la rappresentazione semantica per ciascuna parola. Questo tipo di operazione è fondamentale per molte applicazioni dell’NLP come la tokenizzazione, lo stemming, il part-of-speech tagging, etc.

- Sintassi: a questo livello abbiamo le differenti regole grammaticali che consentono la costruzione di frasi grammaticalmente corrette. I parser sintattici che stanno alla base dei sistemi di NLP hanno proprio la capacità di scoprire la struttura grammaticale della frase, con gli specifici legami di dipendenza che connettono le parole tra loro.

- Semantica: l’elaborazione semantica determina i possibili significati di una frase concentrandosi sulle interazioni tra i significati a livello di parola nella frase. Questo livello di elaborazione può includere la disambiguazione semantica delle parole con sensi multipli; in modo analogo a come la disambiguazione sintattica delle parole che possono funzionare come parti multiple del discorso è realizzata a livello sintattico. La disambiguazione semantica permette di selezionare uno e un solo senso delle parole polisemiche e di includerlo nella rappresentazione semantica della frase. Se per la disambiguazione fossero necessarie informazioni dal resto della frase, il livello semantico, non quello lessicale, farebbe la disambiguazione.

- Contesto: a questo livello l’elaborazione del significato non riguarda più singole sequenze di parole o di frasi, bensì il discorso o più precisamente il testo nel suo complesso. Tuttavia, oltre che il contesto linguistico, appartengono al contesto anche le conoscenze extralinguistiche più proprie della pragmatica che richiedono un certo grado di conoscenza del mondo – come la capacità di intendere la forza illocutoria delle frasi oppure l’interpretazione della polarità dei giudizi. Alcune applicazioni di NLP possono utilizzare moduli di inferenza.

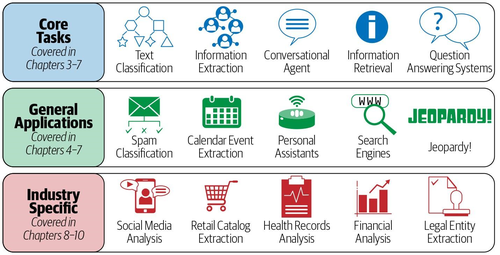

Come si può notare dall’immagine, relazione ai vari livelli linguistici, esiste una collezione molto varia di task all’interno dell’ambito che sta sotto il nome di NLP.

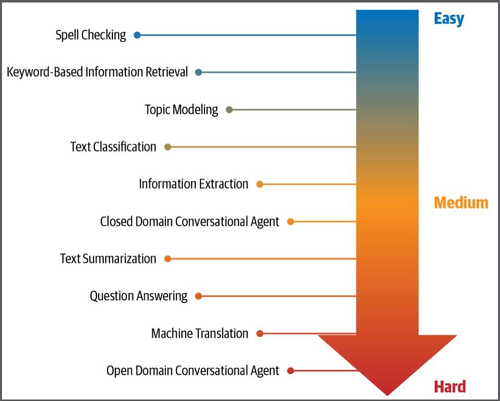

Vediamone alcuni:

- Language modeling. Questo task parte dall’assunzione che predire una parola in una frase si basi sulla storia delle precedenti parole. L’obiettivo di questo task è quello di determinare, tramite l’utilizzo di svariate tecniche probabilistiche e statistiche, la probabilità di una sequenza di parole che appare in un dato linguaggio. Questi modelli sono chiamati n-gram models e sono fondamentali per numerose applicazioni come lo speech recognition, l’optical character recognition, l’handwriting recognition, la machine translation e lo spelling correction.

- Text classification. Questo task ha l’obiettivo di classificare un testo in base al suo contenuto all’interno di un set noto di categorie. Può essere utilizzato per organizzare, strutturare e categorizzare qualsiasi tipo di testo e, per questo, è molto diffuso in una grande varietà di strumenti dall’identificazione di e-mail spam o di documenti e files al sentiment analysis – ovvero l’identificazione della polarità delle opinioni dai testi.

- Information Extraction. Questo task si occupa di estrarre informazioni rilevanti dal testo e fornirne una rappresentazione strutturata. È utilizzata, per esempio, per estrarre calendari di eventi dalle emails.

- Information Retrieval. Questo task serve per la ricerca, a partire da una vasta collezione di documenti, di documenti rilevanti per le richieste fatte dagli utenti. Per citare un esempio, Google Search è un caso molto noto di questo tipo di task.

- Conversational Agent. Un agente conversazionale è un qualsiasi sistema di dialogo automatico in grado di conversare tramite lingue umane. Alexa e Siri rappresentano gli esempi più celebri.

- Text Summarization. Questo processo è teso alla creazione di brevi riassunti di documenti di una certa lunghezza, cercando di preservare il contenuto centrale e il significato generale del testo.

- Question Answering. Si tratta di sistemi che rispondono in maniera automatica a domande poste nel linguaggio naturale, andando a recuperare in maniera non supervisionata informazioni precise che soddisfino la domanda.

- Machine Translation. Questo è il task che si propone di convertire un testo da una lingua L1 a una lingua L2. Applicazioni di questo task sono Google Translate o il più recente DeepL.

- Topic Modeling. Questo task si propone di scoprire la struttura argomentativa e semantica astratta di una grande collezione di documenti. La modellazione dell'argomento è uno strumento comune di text-mining ed è usato in una vasta gamma di domini, dalla letteratura alla bioinformatica.

ALCIDE: Un caso di analisi storica tramite NLP.

Le tecnologie sviluppate nell’ambito dell’NLP, come abbiamo visto, possono avere svariate applicazioni, oltre a quelle sopra accennate. Difatti, questi strumenti si rivelano di grande utilità anche nell’ambito dell’analisi storica e letteraria. Nello specifico, come abbiamo detto in precedenza in maniera più generale, anche per quanto riguarda la storia si è assistito a una sempre maggiore disponibilità e accessibilità a testi storici in formato digitale. La digitalizzazione dei documenti storici è chiaramente motivata da una più generale volontà di preservazione del patrimonio storico in concomitanza con la volontà di rendere accessibili a un pubblico ampio – fatto di specialisti e non – tale patrimonio. D’altra parte, contemporaneamente a una maggiore accessibilità ai materiali storici, si assiste anche al crescente interesse nell’applicazione di metodi e strumenti di NLP allo studio e all’analisi della storia. Questo tipo di applicazioni si rivela di importanza cruciale per la storia digitale, disciplina il cui statuto epistemologico è tanto dibattuto. [11]

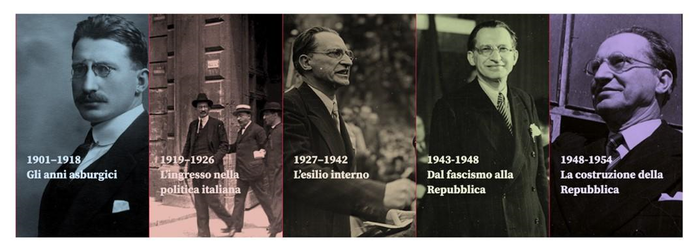

Per comprendere nel dettaglio le potenzialità di tali applicazioni in ambito storico, citiamo l’esempio del progetto ALCIDE [12] : frutto della collaborazione, a partire dal 2013, dell’Istituto Storico Italo-Germanico e del gruppo Digital Humanities della Fondazione Bruno Kessler di Trento, si tratta di una piattaforma digitale il cui scopo è quello di fornire una nuova prospettiva sullo studio e la comprensione della visione politica di Alcide De Gasperi. Partendo dalla centralità delle tecniche discorsive nella costruzione del consenso politico, questo progetto, caratterizzato da un ampio afflato interdisciplinare, ha visto la collaborazione di storici e di informatici umanistici, la cui commistione di competenze ha consentito di analizzare una collezione di 2.762 documenti – circa 3.000.000 parole – compresi nell’arco temporale che va dal 1901 al 1954. Il progetto, nella sua scansione temporale, ha richiesto due fasi: la prima, conclusasi nel 2015, durante la quale la maggior parte degli sforzi si è focalizzata nello sviluppo di un’infrastruttura che permettesse l’analisi automatizzata dei testi e ha coinvolto anche il lavoro degli storici i quali hanno definito i quesiti della ricerca; la seconda, conclusasi nel 2017, si è invece concentrata sullo ricerca più in senso stretto – ossia sullo studio delle mille sfaccettature di De Gasperi nei diversi contesti politici.

Partendo dall’edizione in PDF dei volumi degli Scritti e discorsi politici di Alcide De Gasperi – editi da Il Mulino e contenenti all’interno articoli di giornale, saggi, interventi politici e istituzionali, documenti diplomatici organizzati secondo un ordine cronologico-tematico – gli studiosi hanno creato un corpus di file XML al cui interno si trovavano i vari documenti corredati di metadati. La selezione dei tag di annotazione ha seguito due linee fondamentali: da un lato, un’annotazione che riguardasse i differenti ruoli pubblici rivestiti da De Gasperi durante la sua carriera – che ha consentito di ricostruire le diverse strategie di comunicazione adottate dal politico a seconda del contesto; dall’altro, un’annotazione dei differenti tipi di documenti – che ha permesso di capire quale fosse il contenuto del documento, il pubblico e l’impatto di quel discorso. Questo tipo di annotazione è stata fatta in maniera semiautomatica che, facendo riferimento ad alcuni metadati come il titolo o la data del documento, hanno classificato quale ruolo di volta in volta De Gasperi stava ricoprendo e in quali circostanze quel documento è stato elaborato. Chiaramente, in un secondo momento quest’annotazione è stata soggetta a revisione manuale. Per quanto concerne le tecniche di NLP adottate, come si legge nel sito della piattaforma «Il trattamento del testo a livello linguistico è avvenuto attraverso l'utilizzo di vari tool di NLP (Natural Language Processing) per la lingua italiana. Per la segmentazione del testo, l'estrazione di lemmi, parti del discorso, nomi propri di persona e di luoghi geografici sono state usate le pipeline di analisi TextPro e Tint. I concetti chiave invece sono stati estratti con Keyphrase Digger (KD). La georeferenziazione delle entità geografiche si è appoggia a Nominatim».[13] È stato poi costruito un benchmark che valutasse le performance del Named Entity Recognizer (NER) e del PoS-tagger e, laddove le performance si erano rivelate più basse, si sono apportate delle modifiche e revisioni agli strumenti utilizzati in maniera tale che dopo una seconda esecuzione avessero una qualità migliore e potessero essere utilizzate in modo più affidabile dagli studiosi di storia. Una seconda parte del progetto, a partire dal 2017, è stata dedicata all’individuazione dei contesti e dei ruoli ricoperti da De Gasperi. In particolare, uno degli oggetti di questa indagine è stato il suo del passato, del presente e del futuro nei documenti pubblici: si tratta di un aspetto fondamentale per la comprensione delle strategie retoriche di De Gasperi, per l’importante discorsiva che questi elementi argomentativi e stilistici rivestono all’interno del discorso politico. Infatti, come riporta l’articolo:

«For example, as stated by Aristotle in the first book of the “Rhetoric” (2010), future represents the time for political action and thus it is used to influence the behavior of the audience. On the other hand, references to the past are used to highlight the continuity between elements of a collective history […] and the present, so to produce a charismatic effect among the public (Shamir, Arthur, and House 1994) ». [14]

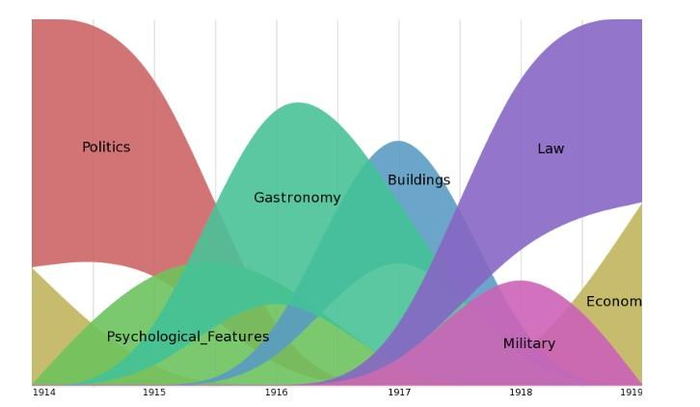

Un ulteriore aspetto di questa seconda fase della ricerca ha riguardato la messa in luce degli argomenti principali del politico nella loro evoluzione nel tempo mediante l’estrazione delle parole chiave all’interno dei discorsi. L’immagine che segue rappresenta in maniera visivamente efficace quelli che sono i domini tematici ricorrenti nei discorsi di De Gasperi nel periodo che va dal 1914 al 1928:

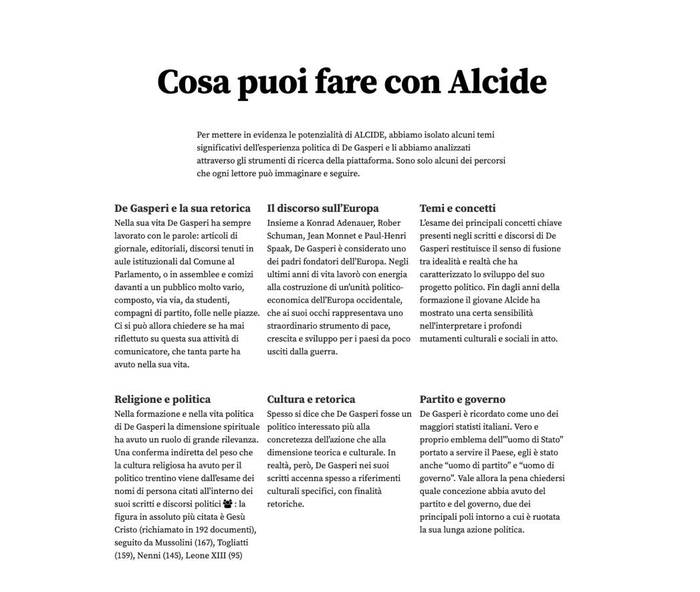

Per quanto riguarda la piattaforma ALCIDE (Analysis of Language and Content In a Digital Environment), questa consente presenta un’interfaccia molto intuitiva e oltre una breve presentazione del progetto, possiede una serie di strumenti per navigare all’interno del corpus. Questa piattaforma rende possibile la navigazione nell’universo culturale e politico degasperiano, rendendo possibile conoscere come cambiano nel tempo e nelle diverse circostanze lo stile comunicativo, le proposte politiche e le figure del mondo politico e culturale degasperiani.

All’interno del sito si trovano delle brevi analisi storiche di alcuni temi significativi dell’esperienza politica di De Gasperi. Se si clicca su una delle tematiche, oltre che una sintesi della tematica e della sua evoluzione nei discorsi del politico, è possibile risalire alle parole chiave che caratterizzano quella tematica tramite dei link.

È possibile, inoltre, navigare all’interno dei vari discorsi, scanditi secondo un ordine cronologico-tematico:

Per quanto riguarda l’esplorazione del corpus, invece, disponiamo di diversi strumenti di ricerca che consentono l’estrazione dei concetti chiave, la ricerca testuale, il riconoscimento dei nomi di persona e di luogo, la visualizzazione dei network, l’individuazione delle co-occorrenze, l’analisi della complessità sintattica e semantica dei testi.

Ciò che emerge dalla realizzazione di ALCIDE ma anche dalle riflessioni precedenti, è lo straordinario contributo che gli strumenti di NLP possono apportare nell’analisi testuale di materiale storico e non solo. Difatti, come afferma lo studioso Lenci, nel solco di una riflessione intorno all’applicazione delle tecnologie informatiche per l’analisi di testi filosofici:

«Una delle sfide più ardue nell’analisi semantica di una parola all’interno dell’opera di un autore. […] una parola può subire forti variazioni semantiche sia a livello intratestuale, come conseguenza dello stile e delle modalità di argomentazione intratestuale sia sul piano intertestuale, come effetto dello sviluppo temporale della riflessione dell’autore. […] La possibilità di ricostruire gli spazi semantici che organizzano il lessico di un autore facendoli emergere direttamente dalla tessitura del testo può dunque offrire una prospettiva interessante e innovativa per l’analisi filosofica».[15]

In conclusione, si può dire che la progressiva digitalizzazione di documenti appartenenti al patrimonio culturale e l’applicazione di strumenti di NLP per lo studio e l’analisi di tale patrimonio, consente di organizzare una notevole mole di dati e di renderla accessibile tanto a un pubblico specialistico quanto a un pubblico generalista. Come sottolinea il ricercatore Maurizio Cau, che ha preso parte al progetto ALCIDE:

«Nell’era della piena condivisione di dati e informazioni gli studi umanistici si vanno aprendo sempre più a modelli di fruizione libera, anche grazie agli sviluppi delle Digital Humanities e alle potenzialità dell’intelligenza artificiale». [16]

Bibliografia e sitografia

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p. V.

- ↑ Ibidem, p. 5.

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p. 117.

- ↑ Ibidem.

- ↑ Ibidem, p. 33-34.

- ↑ Chiari I., 2007, p. 118. Per eventuali approfondimenti sulla tematica, si rimanda a questo collegamento: http://www.hutchinsweb.me.uk/MTNI-14-1996.pdf.

- ↑ Ibidem, p. 118.

- ↑ Wittgenstein L., Ricerche Filosofiche, 2009, §43, p.33.

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p.121.

- ↑ Lenci A., La linguistica computazionale tra informatica e scienze umane: un’applicazione all’analisi semantica dei testi filosofici, in Storia della scienza e linguistica computazionale. Sconfinamenti possibili: Sconfinamenti possibili, 2009, p. 106.

- ↑ Per un approfondimento in merito si rimanda a Salvatori E., Digital (Public) History: la nuova strada di una antica disciplina, 2017.

- ↑ Sprugnoli R., Moretti G., Tonelli S., Menini S., Fifty years of European history through the Lens of Computational Linguistics: the De Gasperi Project, 2016.

- ↑ http://alcidedigitale.fbk.eu.

- ↑ Sprugnoli R., Moretti G., Tonelli S., Menini S., Fifty years of European history through the Lens of Computational Linguistics: the De Gasperi Project, 2016, p. 95-96. In traduzione: «Per esempio, come afferma Aristotele nel primo libro della “Retorica” (2010), il futuro rappresenta il tempo per l’azione politica e quindi viene usato per influenzare il comportamento dell’audience. D’altra parte, i riferimenti al passato sono usati per sottolineare la continuità tra gli elementi di una storia collettiva […] e il presente, in maniera tale da produrre un affascinante effetto tra il pubblico. »

- ↑ Lenci A., La linguistica computazionale tra informatica e scienze umane: un’applicazione all’analisi semantica dei testi filosofici, in Storia della scienza e linguistica computazionale. Sconfinamenti possibili: Sconfinamenti possibili, 2009, p. 106.

- ↑ https://www.fbk.eu/it/press-releases/nasce-la-piattaforma-alcide/.

| Citazione di questo articolo |

| Come citare: MESINA, Veronica . "Natural Language Processing (NLP)". In: CLIOMATICA - Portale di Storia Digitale e ricerca. Disponibile in: http://lhs.unb.br/cliomatica/index.php/Natural_Language_Processing_(NLP). il giorno: 1/06/2024. |

| Informare errori in questa pagina |