Mudanças entre as edições de "Natural Language Processing (NLP)"

| Linha 43: | Linha 43: | ||

<BLOCKQUOTE> «Grazie a questo cambiamento di paradigma epistemologico, oggi la linguistica computazionale è in grado di far emergere nuove sinergie tra le scienze umane e le metodologie informatiche».<ref> Lenci A., ''La linguistica computazionale tra informatica e scienze umane: un’applicazione all’analisi semantica dei testi filosofici, in Storia della scienza e linguistica computazionale. Sconfinamenti possibili: Sconfinamenti possibili'', 2009, p. 106. </ref> </BLOCKQUOTE> | <BLOCKQUOTE> «Grazie a questo cambiamento di paradigma epistemologico, oggi la linguistica computazionale è in grado di far emergere nuove sinergie tra le scienze umane e le metodologie informatiche».<ref> Lenci A., ''La linguistica computazionale tra informatica e scienze umane: un’applicazione all’analisi semantica dei testi filosofici, in Storia della scienza e linguistica computazionale. Sconfinamenti possibili: Sconfinamenti possibili'', 2009, p. 106. </ref> </BLOCKQUOTE> | ||

| + | |||

| + | == '''Applicazioni dell’NLP''' == | ||

| + | |||

| + | |||

}} | }} | ||

Edição das 19h07min de 31 de março de 2021

Storia dell’NLP

Il Natural Language Processing (NLP), nella sua definizione più generale, si riferisce al trattamento automatico del linguaggio mediante l’uso di strumenti elettronici di computazione, ossia di computer. Sotto una certa luce, la Linguistica Computazionale (LC) e l’NLP possono essere concepite come due facce della medesima medaglia. D’altra parte, però, secondo alcuni studiosi questa concezione può essere riduzionistica e semplicistica. Nella Prefazione di Tullio De Mauro al libro di Isabella Chiari Introduzione alla linguistica computazionale, lo studioso sottolinea la necessità di distinguere il piano teorico dal piano applicativo: il primo, è il piano di una teoria o scienza generale tesa all’analisi descrittiva delle lingue mediante l’uso dei computer; il secondo, è il cosiddetto piano dello sviluppo delle tecnologie ingegneristiche e computazionali – nelle parole di De Mauro «di quegli straordinari prolungamenti automatizzati delle nostre mani e occhi e della nostra memoria che sono i computer e le loro applicazioni» [1] . Se nella storia questi due ambiti hanno seguito talvolta un andamento parallelo, ormai i loro percorsi convergono e si intrecciano sempre più intensamente per andare a restituire un resoconto plurale e quindi sempre più fedele alla problematicità di ciò che va sotto il nome di ‘lingua’ e di tutte le sue manifestazioni. Inoltre, se è vero che le riflessioni intorno alla natura del linguaggio e al suo funzionamento hanno radici tanto solide quanto lontane nella storia dell’uomo – dall’antichità fino ad oggi – è altrettanto vero che anche le riflessioni intorno alla creazione di esseri artificiali e linguaggi formali poggiano le loro fondamenta in là nel tempo.

«L’ambizione a creare esseri artificiali, meccanici, che svolgessero azioni solitamente svolte da esseri viventi, animali e uomini, è sempre stata nella fantasia dell’uomo, dalle ideazioni degli ingegneri alessandrini alle teste parlanti medioevali, fino ai veri e propri automi (dal greco autòmatos, «che agisce da sé»), macchine che, sulla base di istruzioni, eseguono un’azione o compiono atti di tipo linguistico» [2].

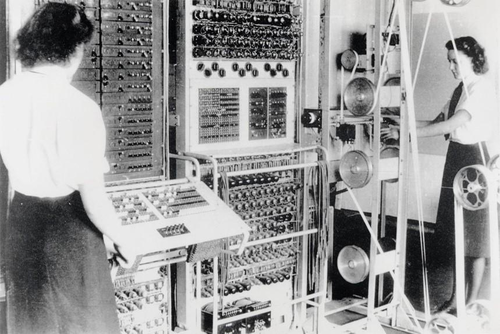

Infatti, l’episteme filosofica cinquecentesca e seicentesca fortemente influenzata dalle diverse scoperte scientifiche che hanno contrassegnato i due secoli, fa emergere come filo conduttore l’intreccio della riflessione intorno agli automi e le lingue artificiali: da Cartesio, ad Hobbes fino ad arrivare a Leibniz la riflessione filosofica fa emergere sempre di più quelli che sono i tratti comuni tra il linguaggio naturale e il linguaggio algebrico. Tuttavia, è soltanto durante il Novecento, in seno a tutte le riflessioni della logica e della filosofia del linguaggio e a fronte di esigenze politiche e belliche, che si concretizza l’idea di costruire delle macchine capaci di manipolare segni linguistici. Infatti, il primo calcolatore logico programmabile, denominato Colossus per le sue dimensioni, è stato messo a punto dagli inglesi nel pieno della Seconda Guerra Mondiale per decriptare le comunicazioni segrete tra Hitler e i suoi generali – queste ultime, a loro volta, criptate mediante la macchina Enigma.

D’altronde, nello stesso periodo, l’ingegnere e matematico Warren Weaver, autore insieme a Claude Shannon della Teoria matematica della comunicazione del 1949, mise in rilievo le forti assonanze tra l’operazione di traduzione e l’operazione di crittografia: entrambi rappresentano processi di trasmissione e codifica dell’informazione, di «trasposizione di un messaggio da un codice a un altro, esattamente come la trascrizione di un testo scritto in alfabeto Morse o in una scrittura segreta» [3].

Durante la Guerra Fredda la paura della guerra nucleare incentivò la ricerca e lo sviluppo nell’ambito del natural language processing – a cominciare dalla necessità di tradurre la lingua russa scritta e parlata nell’inglese americano. Pertanto, si può dire che l’NLP nasce e si configura focalizzandosi inizialmente sulla traduzione automatica, che per il basso costo d’errore e la rapidità di decodifica rappresentava uno strumento vitale per gli Stati Uniti in termini di costi e benefici di guerra. Il primo esperimento pubblico di traduzione automatica ha avuto luogo nel 1954 all’Università di Georgetown negli Stati Uniti con l’uso di un sistema IBM per la traduzione di un numero ristretto di frasi, per l’appunto, dal russo all’inglese sulla base di un altrettanto ristretto vocabolario di parole. In questa prima fase di sviluppo, infatti, i sistemi di traduzione automatica consistevano nella combinazione di statistiche e regole del linguaggio e soprattutto di tavole di corrispondenza tra le parole di una lingua e il corrispettivo nell’altra lingua. Il risultato elaborato da questi primi sistemi rudimentali non poteva essere altro che una traduzione letterale, molto limitata a cui doveva accompagnarsi un’indispensabile revisione umana.

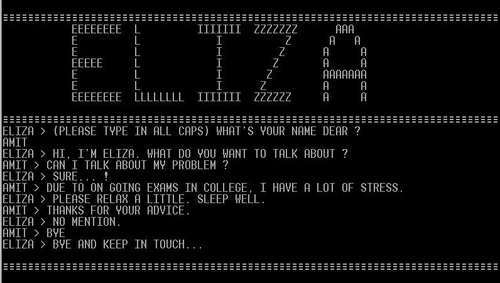

Gli anni che vanno dal 1954 al 1966 sono anni di grande sviluppo per l’NLP, l’AI (Artificial Intelligence) e l’LC. Emblematica in questo senso è la conferenza che si tenne nel 1956 al Dartmouth College nel New Hampshire, durante la quale John McCarthy coniò l’espressione Artificial Intelligence, approfondendone tutte le tematiche ad essa legate [4].4 Nel 1957 Noam Chomsky pubblica il suo libro Syntactic Structure, il cui paradigma modellistico influenzò differenti ambiti – la linguistica teorica, la linguistica computazionale, la filosofia del linguaggio e della mente, le scienze cognitive, etc. Altra data storica è il 1966, la cui importanza riguarda la creazione di ELIZA, primo chatterbot della storia: creato da Joseph Weizenbaum al MIT (Massachussetts Institute of Technology), si trattava di automa per la conversazione con umani, che impersonava una psicologa artificiale. Il funzionamento di ELIZA si fondava sull’analisi del testo e l’individuazione di parole-chiave, usate in seconda istanza per produrre risposte appropriate alle richieste degli utenti. ELIZA riscosse un grande successo – per la sua capacità di dare spesso agli utenti l’illusione di una vera e propria comprensione reciproca – e diede avvio alla creazione di numerosi altri chatterbots – tra gli altri, SHRDLU di Winograd e LUNAR di Woods [5].

Tuttavia, a questa prima fase di grande entusiasmo seguì una battuta d’arresto: nel 1966 l’ALPAC (Automatic Language Processing Advisory Commitee) affermò che i risultati delle ricerche nell’ambito della traduzione automatica avevano delle tempistiche troppo lunghe e non avevano effettivamente portato a dei benefici qualitativi e quantitativi tali da rendere la traduzione automatica più conveniente di quella manuale e umana [6].

Nella seconda metà degli anni ’70, l’NLP torna alla ribalta e riceve una nuova spinta vitale, in un’ottica più realistica e concreta:

«Al semplice confronto lessicale sono affiancate e integrate componenti di analisi morfologica, sintattica e disambiguatori semantici, per consentire alla traduzione in output una maggiore corrispondenza complessiva al testo originale. Il primo dei grandi sistemi di traduzione commerciale di successo, che ancora oggi è utilizzato in molte versioni, fu Systran (acronimo composto di System Translation), sviluppato proprio a partire dagli anni Settanta. Systran nasce come sistema di traduzione diretta dal russo all’inglese, e in seguito introduce moduli complessi di analisi sintattica e lessicale e nuove coppie di lingue. Esso diviene uno dei sistemi più̀ usati anche da organismi internazionali come la Nato, l’aeronautica americana e l’Unione europea, ma anche da aziende come Xerox o General Motors. Sempre negli anni Settanta iniziano a farsi conoscere i primi progetti di traduzione automatica sviluppati in Giappone, paese che ha sempre giocato un ruolo importantissimo nella ricerca in questo settore». [7]

Come si può notare, da questo momento in poi, una grande spinta propulsiva e finanziaria fu data sia da parte di organismi internazionali come la UE, la Nato e l’Onu sia da parte delle grandi multinazionali.

Esistono fondamentalmente due tipi di famiglie di modelli per la traduzione automatica: la prima, è la famiglia dei cosiddetti sistemi basati su regole – rulebased MT (machine translation) – ossia, modelli basati su un insieme circoscritto di regole formali di trascrizione e trasformazione delle unità linguistiche; la seconda, è la famiglia composta dai sistemi probabilistici – ossia, basati su dati disponibili sotto forma di corpora. La prima famiglia ha caratterizzato l’arco temporale che va dagli anni ’50-’70; la seconda l’arco temporale che va dagli anni ’80-’90. Il passaggio dai modelli a regole ai modelli statistici ha segnato anche un cambio di prospettiva sul piano teorico. Difatti, i modelli basati su sistemi probabilistici e statistici, fin dalla loro comparsa, si sono dimostrati molto validi e promettenti in termini di prestazioni e questo ha comportato una revisione delle modalità d’accesso al linguaggio, diverse dalla visione sintattica e combinatoria della lingua tipica del generativismo. La possibilità di poter analizzare la lingua da un punto di vista probabilistico è legato al fatto che la lingua stessa, anche solo da un punto di vista teorico, può essere concepita come un sistema probabilistico che genera sequenze grammaticali di parole. Il fatto che la lingua possa esser concepita come un sistema probabilistico consente la creazione di un modello linguistico stocastico (MLS), o language model, del sistema che genera le sequenze linguistiche. La probabilità che una frase sia enunciata nell’uso è determinata da diversi vincoli linguistici: regole sintattiche, proprietà semantiche, convenzioni d’uso, circostanze pragmatiche. Esiste quindi una stretta relazione tra il grado di grammaticalità di una frase e la probabilità che questa stessa frase venga enunciata. Infatti, i fenomeni linguistici, in quanto prodotti da un sistema probabilistico, possono essere spiegati e quindi previsti attraverso un modello probabilistico costruito a partire da un corpus di addestramento fatto di osservazioni del comportamento del sistema. Queste ultime ci serviranno infatti per stimare quelli che sono i parametri del modello probabilistico, ossia le diverse probabilità che compongono un modello. Il corpus di addestramento di un MLS deve essere un campione rappresentativo dei testi di una lingua. I dati estratti a partire dall’osservazione del corpus di addestramento sono in seguito usati per valutare la probabilità del verificarsi degli eventi prodotti dall’MLS. La bontà del modello è successivamente valutata in base alla sua capacità di prevedere correttamente o meno il comportamento futuro del sistema. Conseguentemente, il modello sarà allora tanto più accurato quanto più sarà in grado di prevedere correttamente quali sono le sequenze grammaticali della lingua dei testi del corpus: ovvero, se sarà in grado di assegnare una probabilità maggiore a sequenze che appartengono alla grammatica della lingua rispetto a quelle che non vi appartengono. Inoltre, il valore del modello risiede anche chiaramente nella sua generalità, ossia nella sua capacità di farci fare previsioni su nuovi dati, diversi da quello su cui è stato addestrato. In ultimo, chiaramente, la generalità del modello dipende a sua volta dalla rappresentatività del corpus di addestramento scelto rispetto al fenomeno da spiegare. In sintesi, questi modelli studiano la lingua per come si manifesta a livello distribuzionale nel suo uso.

Questo approccio mostra anche un cambio di segno teorico ulteriore che, solo a uno sguardo superficiale, può rimanere solo sullo sfondo: con l’affermarsi di questi modelli si assiste a un graduale orientamento dello studio della lingua da un punto di vista esclusivamente formale – tipico del linguista teorico tradizionale – a un punto di vista usage-based. Difatti, una concezione distribuzionale della lingua e dei suoi significati altro non è che un approccio quantitativo e probabilistico alla più teorica affermazione squisitamente wittgensteiniana per cui «Il significato di una parola è il suo uso nel linguaggio». [8]

Oltre che per le motivazioni prettamente teoriche di cui abbiamo appena parlato, il successo dei modelli probabilistici è legato anche a fattori di natura pragmatica: da un lato, il progressivo miglioramento dei computer in termini di potenza di calcolo e memoria, fatto che ha comportato una maggiore capacità e flessibilità dei calcolatori di analizzare e manipolare grandi quantità di dati – anche linguistici; dall’altro, la possibilità di addestrare i sistemi su grandi quantità di dati insieme con l’avvento di internet si accompagnano a una sempre maggiore disponibilità di grandi quantità di dati linguistici in formato elettronico – da cui consegue la possibilità ulteriore di un campionamento sempre più ampio e diversificato di una lingua nel suo uso. Con l’avvento del web e il progressivo miglioramento della rete delle telecomunicazioni ha infatti comportato non solo una crescente disponibilità di materiali linguistici, ma anche l’uso del web stesso come un corpus nel quale poter osservare la lingua nel suo uso.

Per questo motivo, i sistemi attuali sono dei sistemi ibridi che tentano di fare una ricca commistione di metodologie basate su regole formali con metodologie statistiche basate su corpora, in maniera tale sviluppare strategie diversificate e sempre più mirate agli specifici problemi linguistici da affrontare. Questo è ciò che spinge la studiosa Isabella Chiari ad affermare: «La flessibilità dei modelli ibridi è anch’essa un indicatore teorico non marginale che suggerisce una rappresentazione della produzione linguistica come un insieme di strategie (e non come un percorso seriale) adoperabili in relazione a specifiche condizioni linguistiche ed extralinguistiche di utenza». [9]

L’ibridazione dei modelli – che dagli anni ’80 in poi ha caratterizzato una nuova episteme neo-empirista – ha consentito di porre al centro, da un lato, il dato testuale come frutto dell’uso reale e concreto di una lingua, e dall’altro, lo studio delle regolarità distribuzionali delle parole come possibile strumento di ricostruzione semantica. Con le parole dello studioso Lenci:

«Grazie a questo cambiamento di paradigma epistemologico, oggi la linguistica computazionale è in grado di far emergere nuove sinergie tra le scienze umane e le metodologie informatiche».[10]

Applicazioni dell’NLP

Bibliografia e sitografia

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p. V.

- ↑ Ibidem, p. 5.

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p. 117.

- ↑ Ibidem.

- ↑ Ibidem, p. 33-34.

- ↑ Chiari I., 2007, p. 118. Per eventuali approfondimenti sulla tematica, si rimanda a questo collegamento: http://www.hutchinsweb.me.uk/MTNI-14-1996.pdf.

- ↑ Ibidem, p. 118.

- ↑ Wittgenstein L., Ricerche Filosofiche, 2009, §43, p.33.

- ↑ Chiari I., Introduzione alla linguistica computazionale, 2007, p.121.

- ↑ Lenci A., La linguistica computazionale tra informatica e scienze umane: un’applicazione all’analisi semantica dei testi filosofici, in Storia della scienza e linguistica computazionale. Sconfinamenti possibili: Sconfinamenti possibili, 2009, p. 106.

| Citazione di questo articolo |

| Come citare: MESINA, . "Natural Language Processing (NLP)". In: CLIOMATICA - Portale di Storia Digitale e ricerca. Disponibile in: http://lhs.unb.br/cliomatica/index.php/Natural_Language_Processing_(NLP). il giorno: 1/07/2024. |

| Informare errori in questa pagina |