Natural Language Processing (NLP)

Storia dell’NLP

Il Natural Language Processing (NLP), nella sua definizione più generale, si riferisce al trattamento automatico del linguaggio mediante l’uso di strumenti elettronici di computazione, ossia di computer. Sotto una certa luce, la Linguistica Computazionale (LC) e l’NLP possono essere concepite come due facce della medesima medaglia. D’altra parte, però, secondo alcuni studiosi questa concezione può essere riduzionistica e semplicistica. Nella Prefazione di Tullio De Mauro al libro di Isabella Chiari Introduzione alla linguistica computazionale, lo studioso sottolinea la necessità di distinguere il piano teorico dal piano applicativo: il primo, è il piano di una teoria o scienza generale tesa all’analisi descrittiva delle lingue mediante l’uso dei computer; il secondo, è il cosiddetto piano dello sviluppo delle tecnologie ingegneristiche e computazionali – nelle parole di De Mauro «di quegli straordinari prolungamenti automatizzati delle nostre mani e occhi e della nostra memoria che sono i computer e le loro applicazioni» [1] . Se nella storia questi due ambiti hanno seguito talvolta un andamento parallelo, ormai i loro percorsi convergono e si intrecciano sempre più intensamente per andare a restituire un resoconto plurale e quindi sempre più fedele alla problematicità di ciò che va sotto il nome di ‘lingua’ e di tutte le sue manifestazioni. Inoltre, se è vero che le riflessioni intorno alla natura del linguaggio e al suo funzionamento hanno radici tanto solide quanto lontane nella storia dell’uomo – dall’antichità fino ad oggi – è altrettanto vero che anche le riflessioni intorno alla creazione di esseri artificiali e linguaggi formali poggiano le loro fondamenta in là nel tempo.

«L’ambizione a creare esseri artificiali, meccanici, che svolgessero azioni solitamente svolte da esseri viventi, animali e uomini, è sempre stata nella fantasia dell’uomo, dalle ideazioni degli ingegneri alessandrini alle teste parlanti medioevali, fino ai veri e propri automi (dal greco autòmatos, «che agisce da sé»), macchine che, sulla base di istruzioni, eseguono un’azione o compiono atti di tipo linguistico» [2].

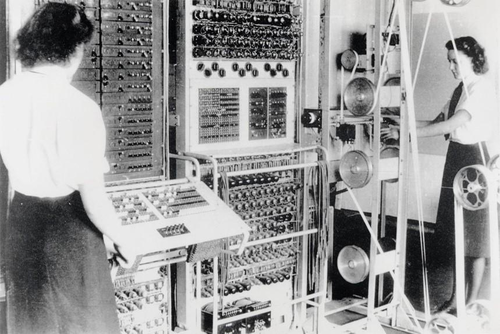

Infatti, l’episteme filosofica cinquecentesca e seicentesca fortemente influenzata dalle diverse scoperte scientifiche che hanno contrassegnato i due secoli, fa emergere come filo conduttore l’intreccio della riflessione intorno agli automi e le lingue artificiali: da Cartesio, ad Hobbes fino ad arrivare a Leibniz la riflessione filosofica fa emergere sempre di più quelli che sono i tratti comuni tra il linguaggio naturale e il linguaggio algebrico. Tuttavia, è soltanto durante il Novecento, in seno a tutte le riflessioni della logica e della filosofia del linguaggio e a fronte di esigenze politiche e belliche, che si concretizza l’idea di costruire delle macchine capaci di manipolare segni linguistici. Infatti, il primo calcolatore logico programmabile, denominato Colossus per le sue dimensioni, è stato messo a punto dagli inglesi nel pieno della Seconda Guerra Mondiale per decriptare le comunicazioni segrete tra Hitler e i suoi generali – queste ultime, a loro volta, criptate mediante la macchina Enigma.

D’altronde, nello stesso periodo, l’ingegnere e matematico Warren Weaver, autore insieme a Claude Shannon della Teoria matematica della comunicazione del 1949, mise in rilievo le forti assonanze tra l’operazione di traduzione e l’operazione di crittografia: entrambi rappresentano processi di trasmissione e codifica dell’informazione, di «trasposizione di un messaggio da un codice a un altro, esattamente come la trascrizione di un testo scritto in alfabeto Morse o in una scrittura segreta» [3].

Durante la Guerra Fredda la paura della guerra nucleare incentivò la ricerca e lo sviluppo nell’ambito del natural language processing – a cominciare dalla necessità di tradurre la lingua russa scritta e parlata nell’inglese americano. Pertanto, si può dire che l’NLP nasce e si configura focalizzandosi inizialmente sulla traduzione automatica, che per il basso costo d’errore e la rapidità di decodifica rappresentava uno strumento vitale per gli Stati Uniti in termini di costi e benefici di guerra. Il primo esperimento pubblico di traduzione automatica ha avuto luogo nel 1954 all’Università di Georgetown negli Stati Uniti con l’uso di un sistema IBM per la traduzione di un numero ristretto di frasi, per l’appunto, dal russo all’inglese sulla base di un altrettanto ristretto vocabolario di parole. In questa prima fase di sviluppo, infatti, i sistemi di traduzione automatica consistevano nella combinazione di statistiche e regole del linguaggio e soprattutto di tavole di corrispondenza tra le parole di una lingua e il corrispettivo nell’altra lingua. Il risultato elaborato da questi primi sistemi rudimentali non poteva essere altro che una traduzione letterale, molto limitata a cui doveva accompagnarsi un’indispensabile revisione umana.

Gli anni che vanno dal 1954 al 1966 sono anni di grande sviluppo per l’NLP, l’AI (Artificial Intelligence) e l’LC. Emblematica in questo senso è la conferenza che si tenne nel 1956 al Dartmouth College nel New Hampshire, durante la quale John McCarthy coniò l’espressione Artificial Intelligence, approfondendone tutte le tematiche ad essa legate [4].4 Nel 1957 Noam Chomsky pubblica il suo libro Syntactic Structure, il cui paradigma modellistico influenzò differenti ambiti – la linguistica teorica, la linguistica computazionale, la filosofia del linguaggio e della mente, le scienze cognitive, etc. Altra data storica è il 1966, la cui importanza riguarda la creazione di ELIZA, primo chatterbot della storia: creato da Joseph Weizenbaum al MIT (Massachussetts Institute of Technology), si trattava di automa per la conversazione con umani, che impersonava una psicologa artificiale. Il funzionamento di ELIZA si fondava sull’analisi del testo e l’individuazione di parole-chiave, usate in seconda istanza per produrre risposte appropriate alle richieste degli utenti. ELIZA riscosse un grande successo – per la sua capacità di dare spesso agli utenti l’illusione di una vera e propria comprensione reciproca – e diede avvio alla creazione di numerosi altri chatterbots – tra gli altri, SHRDLU di Winograd e LUNAR di Woods [5].

Bibliografia e sitografia

| Citazione di questo articolo |

| Come citare: MESINA, . "Natural Language Processing (NLP)". In: CLIOMATICA - Portale di Storia Digitale e ricerca. Disponibile in: http://lhs.unb.br/cliomatica/index.php/Natural_Language_Processing_(NLP). il giorno: 1/07/2024. |

| Informare errori in questa pagina |